-

Posts

299 -

Joined

-

Last visited

Converted

-

Gender

Male

-

ICQ

30687897

Recent Profile Visitors

1028 profile views

Smolo's Achievements

Contributor (5/14)

24

Reputation

-

@Jorge After I successively deleted the files, it stopped at some point, i.e. no more display of corrupt files. I am currently using a RAM bar. What do I do now with the remaining errors? Mar 20 09:12:21 Sugo ool www[14282]: /usr/local/emhttp/plugins/dynamix/scripts/btrfs_scrub 'start' '/mnt/cache' '' Mar 20 09:12:21 Sugo kernel: BTRFS info (device nvme0n1p1): scrub: started on devid 1 Mar 20 09:12:21 Sugo kernel: BTRFS info (device nvme0n1p1): scrub: started on devid 2 Mar 20 09:12:21 Sugo kernel: scrub_handle_errored_block: 6910 callbacks suppressed Mar 20 09:12:21 Sugo kernel: btrfs_dev_stat_inc_and_print: 6892 callbacks suppressed Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): bdev /dev/nvme0n1p1 errs: wr 0, rd 0, flush 0, corrupt 15786, gen 0 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): bdev /dev/nvme0n1p1 errs: wr 0, rd 0, flush 0, corrupt 15787, gen 0 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): bdev /dev/nvme0n1p1 errs: wr 0, rd 0, flush 0, corrupt 15788, gen 0 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): bdev /dev/nvme0n1p1 errs: wr 0, rd 0, flush 0, corrupt 15789, gen 0 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): bdev /dev/nvme0n1p1 errs: wr 0, rd 0, flush 0, corrupt 15790, gen 0 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): bdev /dev/nvme0n1p1 errs: wr 0, rd 0, flush 0, corrupt 15791, gen 0 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): bdev /dev/nvme0n1p1 errs: wr 0, rd 0, flush 0, corrupt 15793, gen 0 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): bdev /dev/nvme0n1p1 errs: wr 0, rd 0, flush 0, corrupt 15792, gen 0 Mar 20 09:12:21 Sugo kernel: scrub_handle_errored_block: 6868 callbacks suppressed Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): unable to fixup (regular) error at logical 208361881600 on dev /dev/nvme0n1p1 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): unable to fixup (regular) error at logical 208362405888 on dev /dev/nvme0n1p1 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): unable to fixup (regular) error at logical 208361488384 on dev /dev/nvme0n1p1 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): unable to fixup (regular) error at logical 208362274816 on dev /dev/nvme0n1p1 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): unable to fixup (regular) error at logical 208361750528 on dev /dev/nvme0n1p1 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): unable to fixup (regular) error at logical 208361619456 on dev /dev/nvme0n1p1 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): unable to fixup (regular) error at logical 208362012672 on dev /dev/nvme0n1p1 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): unable to fixup (regular) error at logical 208362143744 on dev /dev/nvme0n1p1 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): bdev /dev/nvme0n1p1 errs: wr 0, rd 0, flush 0, corrupt 15795, gen 0 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): bdev /dev/nvme0n1p1 errs: wr 0, rd 0, flush 0, corrupt 15794, gen 0 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): unable to fixup (regular) error at logical 208361885696 on dev /dev/nvme0n1p1 Mar 20 09:12:21 Sugo kernel: BTRFS error (device nvme0n1p1): unable to fixup (regular) error at logical 208361754624 on dev /dev/nvme0n1p1 Mar 20 09:12:21 Sugo kernel: BTRFS info (device nvme0n1p1): scrub: finished on devid 1 with status: 0 Mar 20 09:12:21 Sugo kernel: BTRFS info (device nvme0n1p1): scrub: finished on devid 2 with status: 0

-

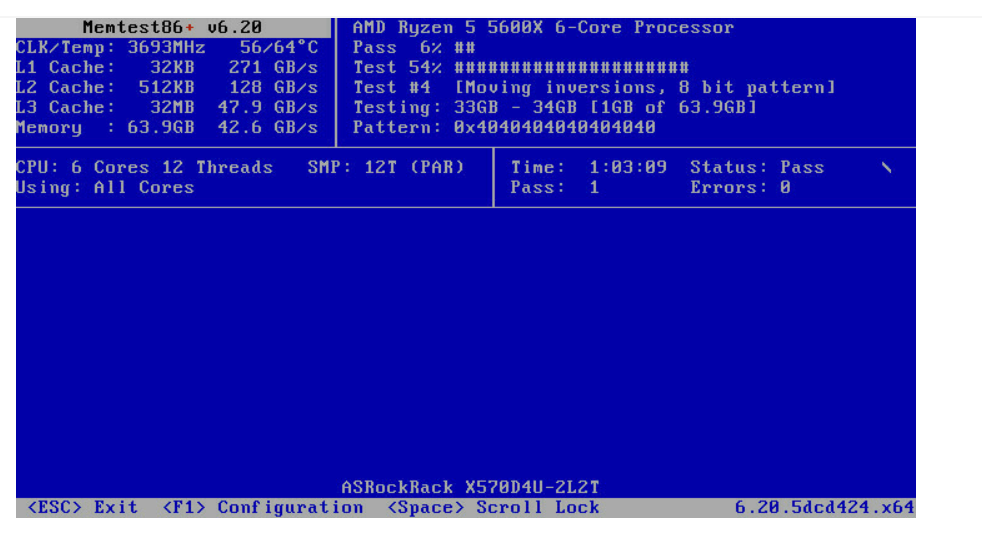

I'm completely at a loss, I've never had anything like this before. Theoretically it can only be the power supply(?), memory, NVME or mainboard. I've already ordered a new power supply, but I can't really imagine what's going on anymore. The memory shouldn't play a role at this point, should it?

-

@Jorge I have now deleted some data but unfortunately the next scrub will show new files as corrupt? The docker file is also affected, how can I restore it or have it recreated? To be honest, I don't really understand why btrfs and a raid 1 system and two ECC RAMs play such an important role? :-(

-

-

I have now run it twice without any results. The first run took over 14 hours. On the second run I reset all BIOS values beforehand without any errors.

-

@JorgeB Here the same problem Cache Pool no longer accessible after a restart. I was able to solve it with btrfs rescue zero-log /dev/nvme1n1p1. Unfortunately the same error came back after a few days. I then ran btrfs resuce zero-log again and wanted to move the data to the array via the mover. Unfortunately, I have massive access errors. Can you possibly help? Mar 18 01:03:07 Sugo kernel: btrfs_print_data_csum_error: 1494 callbacks suppressed Mar 18 01:03:07 Sugo kernel: BTRFS warning (device nvme0n1p1): csum failed root 5 ino 36649273 off 0 csum 0x8941f998 expected csum 0x36d489f9 mirror 1 Mar 18 01:03:07 Sugo kernel: btrfs_dev_stat_inc_and_print: 1494 callbacks suppressed Mar 18 01:03:07 Sugo kernel: BTRFS error (device nvme0n1p1): bdev /dev/nvme1n1p1 errs: wr 0, rd 0, flush 0, corrupt 25951, gen 0 Mar 18 01:03:07 Sugo kernel: BTRFS warning (device nvme0n1p1): csum failed root 5 ino 36649273 off 4096 csum 0x8941f998 expected csum 0xa4cb39d0 mirror 1 Translated with DeepL.com (free version) sugo-diagnostics-20240318-0032.zip

-

Sehr ausführliche Antwort erstmal besten Dank hierfür. Zur Hardware es handelt sich hier um eine 16TB HDD und nicht die SSD aus dem ursprünglichen Problemfall. Ich tippe mittlerweile auch auf ein Hardware Problem bin aber etwas überfragt. - Kabel kann ich mir nicht so recht vorstellen hatte ich nie Probleme mit - Netzteil könnte ich mir am ehesten noch vorstellen das des zu wenig Dunst hat?! - Defektes Mainboard / Controller wäre natürlich nen Totalschaden das kann ich mir aber auch weniger vorstellen. Hotswap wäre mal eine Idee zum deaktivieren. Kann jemand anderes was bezüglich ATA / SATA Meldung im Log sagen und ob das in Ordnung ist? Bezüglich Bau immer noch mitten drin statt nur dabei aber so langsam biegen wir auf die Ziellinie ein ist halt derb wenn man alles selbst macht und das Objekt bissel größer ist

-

Muss den Thread leider noch mal ausbuddeln.... kann damit jemand was anfangen? Start einer Kopieraktion auf eine neue Platte die nur gemounted ist? Nach 1min kopierne = grätsche und Platte ist weg? Dec 21 00:21:18 Sugo emhttpd: read SMART /dev/sdb Dec 21 00:24:14 Sugo kernel: ata1.00: exception Emask 0x0 SAct 0x0 SErr 0x0 action 0x6 frozen Dec 21 00:24:14 Sugo kernel: ata1.00: failed command: FLUSH CACHE EXT Dec 21 00:24:14 Sugo kernel: ata1.00: cmd ea/00:00:00:00:00/00:00:00:00:00/a0 tag 7 Dec 21 00:24:14 Sugo kernel: res 40/00:00:00:00:00/00:00:00:00:00/40 Emask 0x4 (timeout) Dec 21 00:24:14 Sugo kernel: ata1.00: status: { DRDY } Dec 21 00:24:14 Sugo kernel: ata1: hard resetting link Dec 21 00:24:19 Sugo kernel: ata1: link is slow to respond, please be patient (ready=0) Dec 21 00:24:24 Sugo kernel: ata1: found unknown device (class 0) Dec 21 00:24:24 Sugo kernel: ata1: softreset failed (device not ready) Dec 21 00:24:24 Sugo kernel: ata1: hard resetting link Dec 21 00:24:29 Sugo kernel: ata1: link is slow to respond, please be patient (ready=0) Dec 21 00:24:34 Sugo kernel: ata1: found unknown device (class 0) Dec 21 00:24:34 Sugo kernel: ata1: softreset failed (device not ready) Dec 21 00:24:34 Sugo kernel: ata1: hard resetting link Dec 21 00:24:39 Sugo kernel: ata1: link is slow to respond, please be patient (ready=0) Dec 21 00:24:44 Sugo kernel: ata1: found unknown device (class 0) Dec 21 00:24:50 Sugo kernel: ata1: link is slow to respond, please be patient (ready=0) Dec 21 00:25:09 Sugo kernel: ata1: softreset failed (device not ready) Dec 21 00:25:09 Sugo kernel: ata1: limiting SATA link speed to 3.0 Gbps Dec 21 00:25:09 Sugo kernel: ata1: hard resetting link Dec 21 00:25:14 Sugo kernel: ata1: found unknown device (class 0) Dec 21 00:25:14 Sugo kernel: ata1: softreset failed (device not ready) Dec 21 00:25:14 Sugo kernel: ata1: reset failed, giving up Dec 21 00:25:14 Sugo kernel: ata1.00: disable device Dec 21 00:25:14 Sugo kernel: ata1: EH complete Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#16 UNKNOWN(0x2003) Result: hostbyte=0x04 driverbyte=DRIVER_OK cmd_age=122s Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#16 CDB: opcode=0x8a 8a 00 00 00 00 00 00 3c f7 00 00 00 0a 00 00 00 Dec 21 00:25:14 Sugo kernel: I/O error, dev sdb, sector 3995392 op 0x1:(WRITE) flags 0x104000 phys_seg 49 prio class 2 Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#17 UNKNOWN(0x2003) Result: hostbyte=0x04 driverbyte=DRIVER_OK cmd_age=0s Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#17 CDB: opcode=0x8a 8a 00 00 00 00 00 00 3d 01 00 00 00 00 38 00 00 Dec 21 00:25:14 Sugo kernel: I/O error, dev sdb, sector 3997952 op 0x1:(WRITE) flags 0x100000 phys_seg 5 prio class 2 Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#18 UNKNOWN(0x2003) Result: hostbyte=0x04 driverbyte=DRIVER_OK cmd_age=122s Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#18 CDB: opcode=0x35 35 00 00 00 00 00 00 00 00 00 Dec 21 00:25:14 Sugo kernel: I/O error, dev sdb, sector 15032387032 op 0x1:(WRITE) flags 0x9800 phys_seg 1 prio class 2 Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#19 UNKNOWN(0x2003) Result: hostbyte=0x04 driverbyte=DRIVER_OK cmd_age=0s Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#19 CDB: opcode=0x8a 8a 00 00 00 00 00 00 3d 01 38 00 00 0a 00 00 00 Dec 21 00:25:14 Sugo kernel: I/O error, dev sdb, sector 3998008 op 0x1:(WRITE) flags 0x104000 phys_seg 168 prio class 2 Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#20 UNKNOWN(0x2003) Result: hostbyte=0x04 driverbyte=DRIVER_OK cmd_age=0s Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#20 CDB: opcode=0x8a 8a 00 00 00 00 00 00 3d 0b 38 00 00 05 80 00 00 Dec 21 00:25:14 Sugo kernel: I/O error, dev sdb, sector 4000568 op 0x1:(WRITE) flags 0x104000 phys_seg 88 prio class 2 Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#21 UNKNOWN(0x2003) Result: hostbyte=0x04 driverbyte=DRIVER_OK cmd_age=0s Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#21 CDB: opcode=0x8a 8a 00 00 00 00 00 00 3d 10 b8 00 00 08 48 00 00 Dec 21 00:25:14 Sugo kernel: I/O error, dev sdb, sector 4001976 op 0x1:(WRITE) flags 0x100000 phys_seg 70 prio class 2 Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#22 UNKNOWN(0x2003) Result: hostbyte=0x04 driverbyte=DRIVER_OK cmd_age=0s Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#22 CDB: opcode=0x8a 8a 00 00 00 00 00 00 3d 19 00 00 00 05 b0 00 00 Dec 21 00:25:14 Sugo kernel: I/O error, dev sdb, sector 4004096 op 0x1:(WRITE) flags 0x104000 phys_seg 168 prio class 2 Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#23 UNKNOWN(0x2003) Result: hostbyte=0x04 driverbyte=DRIVER_OK cmd_age=0s Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#23 CDB: opcode=0x8a 8a 00 00 00 00 00 00 3d 1e b0 00 00 05 80 00 00 Dec 21 00:25:14 Sugo kernel: I/O error, dev sdb, sector 4005552 op 0x1:(WRITE) flags 0x100000 phys_seg 88 prio class 2 Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#31 UNKNOWN(0x2003) Result: hostbyte=0x04 driverbyte=DRIVER_OK cmd_age=0s Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#31 CDB: opcode=0x8a 8a 00 00 00 00 00 00 3d 24 30 00 00 0a 00 00 00 Dec 21 00:25:14 Sugo kernel: I/O error, dev sdb, sector 4006960 op 0x1:(WRITE) flags 0x104000 phys_seg 160 prio class 2 Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#0 UNKNOWN(0x2003) Result: hostbyte=0x04 driverbyte=DRIVER_OK cmd_age=0s Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#0 CDB: opcode=0x8a 8a 00 00 00 00 00 00 3d 2e 30 00 00 06 00 00 00 Dec 21 00:25:14 Sugo kernel: I/O error, dev sdb, sector 4009520 op 0x1:(WRITE) flags 0x100000 phys_seg 96 prio class 2 Dec 21 00:25:14 Sugo kernel: XFS (sdb1): log I/O error -5 Dec 21 00:25:14 Sugo kernel: sdb: detected capacity change from 31251759104 to 0 Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#14 access beyond end of device Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#15 access beyond end of device Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#16 access beyond end of device Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#17 access beyond end of device Dec 21 00:25:14 Sugo kernel: XFS (sdb1): Filesystem has been shut down due to log error (0x2). Dec 21 00:25:14 Sugo kernel: sd 1:0:0:0: [sdb] tag#18 access beyond end of device Dec 21 00:25:14 Sugo kernel: XFS (sdb1): Please unmount the filesystem and rectify the problem(s). Dec 21 00:25:14 Sugo kernel: sdb1: writeback error on inode 137, offset 171966464, sector 3997952 Dec 21 00:25:14 Sugo kernel: sdb1: writeback error on inode 137, offset 180355072, sector 4005552 Dec 21 00:25:14 Sugo kernel: sdb1: writeback error on inode 137, offset 188743680, sector 4030720 Dec 21 00:25:14 Sugo kernel: sdb1: writeback error on inode 137, offset 197132288, sector 4041984 Dec 21 00:25:14 Sugo kernel: sdb1: writeback error on inode 137, offset 201326592, sector 4044992 Dec 21 00:25:14 Sugo kernel: XFS (sdb1): log I/O error -5 Dec 21 00:25:14 Sugo kernel: XFS (sdb1): log I/O error -5 Dec 21 00:25:14 Sugo kernel: XFS (sdb1): log I/O error -5 Dec 21 00:25:14 Sugo kernel: XFS (sdb1): log I/O error -5

-

Smolo started following Backup vom Array - wohin?

-

Mal eine kurze Frage an die Backup Front ich bin wohl der zahlreichen Software Lösungen und wenig Zeit etwas überfordert. Mein Ziel Von 2-3 PCs (Server/Clients) spezifische Verzeichnisse vom Server aus (Pull) per Scheduler zu sichern. Nur wenn nicht anders möglich mit Clientlösung. Das ganze sollte per Webinterface konfigurierbar sein und wegen Ransomware Möglichkeit im TimeMachine Modus. Gibts da was bzw. was könnt ihr empfehlen?

-

Kurzes Update zu meiner Havarie. Der Hinweis von @JorgeB die emulierte Platte über den nachfolgenden Befehl zu bereinigen war genau die richtige Lösung. Thanks JorgeB. xfs_repair -vL /dev/md4 Natürlich auch an alle anderen vielen lieben Dank für den Support! Zurück zum Thema mir stellen sich hier noch zwei entscheidende Fragen: 1) Es sieht zwar so aus als wenn die Daten wieder da sind aber genau Wissen kann ich es leider nicht. D.h. wenn es das XFS Dateisystem zerlegt kann es trotz Parität zu einem Datenverlust kommen soweit mein aktuelles Verständnis? 2) Ich mache zur Sicherheit noch eine 1:1 Kopie auf eine extra Platte außerhalb des Arrays die 16TB sind schon unterwegs. Aber wie hänge ich die SSD wieder ins Array rein einfach formierten und wieder als Disk 4 hinterlegen?

-

Gewerke vergeben?! Das sind wir zwei Irren (Vater + me) 😁 Bis auf ein paar spezielle Themen (Dach, Putz) machen wir alles allein...hab dieses Jahr schon 80-100m³ Beton gepumpt wird ein Niedrigenergie/Passivhaus. Nachbarn gibts nur bedingt ist ein Neubaugebiet 250m neben nem See. Wir sind eigentlich 18hx7 aufm Bau. Nur der Arzt 150m weiter hat sich mal etwas Lautstark beschwert als ich Sa 20.30 bei Regen die Fenster mit nem 250er Trennjäger bearbeitet hab😂

-

Photorec hab ich schon gesehen eventuell zieh ich die Daten damit erstmal wenn möglich. Dateinamen sind egal Hauptsache der Content ist wieder da. Bin erstmal aufm Bau muss da Abend weitermachen. Danke.

-

Ich habe mich falsch ausgedrückt das ist mir schon klar was die Parity macht in dem Kontext. Das Problem ist doch das es mir wegen einem HW Fehler anscheinend das Dateisystem zerlegt hat und die Parity das nicht rafft und ohne Fehler durchläuft und das kann ich nicht verstehen an dieser Stelle.

-

Does the XFS protocol now only refer to the emulated disk? Will I somehow get the discs back together when I run this?

-

Ja es erscheint kein Fehler und das Verzeichnis ist leer das ist so weit korrekt. Soweit mein aktuelles Verständnis reicht bin ich da aber doch doppelt gekniffen denn das bedeutet die Parity hält die Daten nicht vor und auf der Disk4 kann ich auch nicht direkt/indirekt zugreifen. Warum sollte ich jetzt Daten von DIsk4 rekonstrurieren und auf die emulierte Disk schreiben da bin ich gedanklich jetzt vollkommen raus vom Verständnis? Das mit dem Backup ziehen ist leichter gesagt als getan....ich bin nicht Daheim wo mein ganzer IT Stuff liegt und hab hier nur einen alten Laptop mit einem USB Port🤪...baue grad Häuschen in Eigenleistung 500km entfernt und die ganzen Baubilder liegen in dem Ordner weil ich diese noch nicht ins 3fach gesicherte Storage schieben konnte 😐 Wie ziehe ich denn am leichtesten unter Linux eine 1:1 Bit Kopie einer Platte direkt unter Unraid geht das auch in virtuelle Abbilder? Am liebsten würde ich die Platte zum Datenrestore einschicken es geht eigentlich nur um 50GB Bilder der Rest waren nur x fach gesicherte Kopien auf der Platte die sind mir total wurscht aber der Rest umso wichtiger.