Jack8COke

-

Posts

29 -

Joined

-

Last visited

Content Type

Profiles

Forums

Downloads

Store

Gallery

Bug Reports

Documentation

Landing

Posts posted by Jack8COke

-

-

Hi,

i have moved my cache to another drive and have made a backup before with "Backup/Restore Appdata". I have also copied the storj-certs folder. I could restore every Docker app. But with storj i have errors. I have restored every App and copied the certs into the same location. Here is the log:

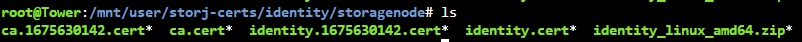

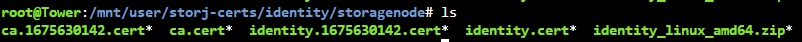

2023-02-27T17:50:04.625+0100 INFO Anonymized tracing enabled {"Process": "storagenode"} 2023-02-27T17:50:04.626+0100 ERROR Failed to load identity. {"Process": "storagenode", "error": "file or directory not found: open identity/identity.key: no such file or directory", "errorVerbose": "file or directory not found: open identity/identity.key: no such file or directory\n\tstorj.io/common/identity.Config.Load:333\n\tmain.cmdRun:182\n\tstorj.io/private/process.cleanup.func1.4:377\n\tstorj.io/private/process.cleanup.func1:395\n\tgithub.com/spf13/cobra.(*Command).execute:852\n\tgithub.com/spf13/cobra.(*Command).ExecuteC:960\n\tgithub.com/spf13/cobra.(*Command).Execute:897\n\tstorj.io/private/process.ExecWithCustomConfigAndLogger:92\n\tmain.main:478\n\truntime.main:250"} Error: Failed to load identity: file or directory not found: open identity/identity.key: no such file or directory storj.io/common/identity.Config.Load:333 main.cmdRun:182 storj.io/private/process.cleanup.func1.4:377 storj.io/private/process.cleanup.func1:395 github.com/spf13/cobra.(*Command).execute:852 github.com/spf13/cobra.(*Command).ExecuteC:960 github.com/spf13/cobra.(*Command).Execute:897 storj.io/private/process.ExecWithCustomConfigAndLogger:92 main.main:478 runtime.main:250 2023-02-27 17:50:04,629 INFO exited: storagenode (exit status 1; not expected) 2023-02-27 17:50:06,635 INFO spawned: 'storagenode' with pid 74 2023-02-27 17:50:06,641 INFO spawned: 'storagenode-updater' with pid 75 2023-02-27T17:50:06.698+0100 INFO Configuration loaded {"Process": "storagenode-updater", "Location": "/app/config/config.yaml"} 2023-02-27T17:50:06.699+0100 INFO Invalid configuration file key {"Process": "storagenode-updater", "Key": "server.private-address"} 2023-02-27T17:50:06.700+0100 INFO Invalid configuration file key {"Process": "storagenode-updater", "Key": "operator.wallet-features"} 2023-02-27T17:50:06.701+0100 INFO Invalid configuration file key {"Process": "storagenode-updater", "Key": "healthcheck.enabled"} 2023-02-27T17:50:06.702+0100 INFO Invalid configuration file key {"Process": "storagenode-updater", "Key": "healthcheck.details"} 2023-02-27T17:50:06.707+0100 INFO Invalid configuration file key {"Process": "storagenode-updater", "Key": "console.address"} 2023-02-27T17:50:06.707+0100 INFO Invalid configuration file key {"Process": "storagenode-updater", "Key": "server.address"} 2023-02-27T17:50:06.707+0100 INFO Invalid configuration file key {"Process": "storagenode-updater", "Key": "storage.allocated-disk-space"} 2023-02-27T17:50:06.708+0100 INFO Invalid configuration file key {"Process": "storagenode-updater", "Key": "storage.allocated-bandwidth"} 2023-02-27T17:50:06.708+0100 INFO Invalid configuration file key {"Process": "storagenode-updater", "Key": "operator.wallet"} 2023-02-27T17:50:06.708+0100 INFO Invalid configuration file key {"Process": "storagenode-updater", "Key": "operator.email"} 2023-02-27T17:50:06.708+0100 INFO Invalid configuration file key {"Process": "storagenode-updater", "Key": "contact.external-address"} 2023-02-27T17:50:06.708+0100 INFO Invalid configuration file value for key {"Process": "storagenode-updater", "Key": "log.encoding"} 2023-02-27T17:50:06.708+0100 INFO Invalid configuration file value for key {"Process": "storagenode-updater", "Key": "log.level"} 2023-02-27T17:50:06.708+0100 INFO Invalid configuration file value for key {"Process": "storagenode-updater", "Key": "log.output"} 2023-02-27T17:50:06.712+0100 INFO Anonymized tracing enabled {"Process": "storagenode-updater"} 2023-02-27T17:50:06.721+0100 FATAL Error loading identity. {"Process": "storagenode-updater", "error": "file or directory not found: open identity/identity.key: no such file or directory", "errorVerbose": "file or directory not found: open identity/identity.key: no such file or directory\n\tstorj.io/common/identity.Config.Load:333\n\tmain.cmdRun:108\n\tstorj.io/private/process.cleanup.func1.4:377\n\tstorj.io/private/process.cleanup.func1:395\n\tgithub.com/spf13/cobra.(*Command).execute:852\n\tgithub.com/spf13/cobra.(*Command).ExecuteC:960\n\tgithub.com/spf13/cobra.(*Command).Execute:897\n\tstorj.io/private/process.ExecWithCustomConfigAndLogger:92\n\tmain.main:20\n\truntime.main:250"} 2023-02-27 17:50:06,727 INFO exited: storagenode-updater (exit status 1; not expected) 2023-02-27T17:50:06.756+0100 INFO Configuration loaded {"Process": "storagenode", "Location": "/app/config/config.yaml"} 2023-02-27T17:50:06.756+0100 INFO Anonymized tracing enabled {"Process": "storagenode"} 2023-02-27T17:50:06.757+0100 ERROR Failed to load identity. {"Process": "storagenode", "error": "file or directory not found: open identity/identity.key: no such file or directory", "errorVerbose": "file or directory not found: open identity/identity.key: no such file or directory\n\tstorj.io/common/identity.Config.Load:333\n\tmain.cmdRun:182\n\tstorj.io/private/process.cleanup.func1.4:377\n\tstorj.io/private/process.cleanup.func1:395\n\tgithub.com/spf13/cobra.(*Command).execute:852\n\tgithub.com/spf13/cobra.(*Command).ExecuteC:960\n\tgithub.com/spf13/cobra.(*Command).Execute:897\n\tstorj.io/private/process.ExecWithCustomConfigAndLogger:92\n\tmain.main:478\n\truntime.main:250"} Error: Failed to load identity: file or directory not found: open identity/identity.key: no such file or directoryMy storj-certs folder looks like this:

He misses an identity.key File. But there was no file with this name before. Someone has an idea?

-

On 9/11/2022 at 11:41 AM, mgutt said:

Ich nutze auch nur eine SSD, ich sichere jede Nacht aufs Array. Mein Potential also 24h. Kann ich mit leben.

Kannst du darauf eingehen. Schiebst du die ganz normal per mover drauf oder sicherst du die mit einem skript auf das array? Ich greife ständig auf die Daten zu und möchte nicht, dass meine hdd's im array ständig an gehen. Daher soll auf der SSD geschrieben werden und Abends dann zusätzlich auf das array gesichert werden.

-

@DataCollector vielen Dank für deine Rückmeldung. Das klingt alles nicht wirklich optimal und eher nach einer Bastellösung, wo ich am Ende nicht wirklich stromsparend unterwegs sein werde. Dann bleibe ich vorerst wahrscheinlich bei meinem jetzigen Aufbau. Der Clevo hat eine 1TB Sata SSD und 1TB nvme als raid verbaut und stellt mir diverse Dienste bereit (Stromverbrauch ca. 15 Watt wenn alle Dienste aktiv sind). Für große Datenmengen wie Mediendateien habe ich einen separaten Server (Dell T30) wo 2*18TB im zfs mirror verbaut sind (Stromverbrauch ca. 35 Watt). Dieser wird nur bei Bedarf eingeschaltet. Wenn es mal wieder Hardware zu vernünftigen Preisen gibt, überdenke ich meinen Aufbau.

-

Hallo Zusammen,

ich besitze einen Clevo N151Zu und lasse darauf unraid laufen. Dort lassen sich leider keine Festplatten einbauen und deshalb will ich einen externen Wechselrahmen nutzen. Ich besitze da bereits:

Im Clevo habe ich die Möglichkeit einen m.2 slot zu nutzen und würde dort gerne diesen Adapter verbauen, der laut Bewertungen mit unraid funktioniert und dort klemme ich dann die Platten an:

Jetzt habe ich noch das Problem, dass ich vom Clevo keinen Molex Stromadapter bekomme. Daher suche ich nach einem externen Netzteil, dass ich an den chenbro Wechselrahmen anschließen kann. Es gibt ja externe Netzteile mit Molex, aber können diese auch bis zu 5 Platten versorgen? Gerade beim anlaufen gönnen diese sich ja gerne mal ein paar Watt mehr. Zum Beispiel das hier:

Oder gibt es eine andere Möglichkeit? Das ganze soll möglichst Platz- und stromsparend sein. Ich will das ganze in mein 19 Zoll Serverschrank packen und das ganze würde dort noch gerade so rein passen. Was neues will ich mir aufgrund der Lieferschwierigkeiten und der unverschämten Preise nicht holen.

Gruß

-

Hi Zusammen,

vielen Dank für die Rückmeldungen. Hab es soweit jetzt zum laufen bekommen. Genau es geht um Sicherheitsbedenken. Dienste die ich nach draußen öffne, sollen in ihrem eigenen Netzwerk laufen und falls dort ein Angriff stattfindet, soll es keinen Zugriff auf mein internes Netzwerk bekommen.

@alturismo was meinst du mit host access in unraid deaktivieren? Wie geht das? Ich habe es jetzt so gelöst, dass ich in meinem pfsense router beide interfaces gegeneinander gesperrt habe. Zusätzlich habe ich noch die IP von unraid und pfsense geblockt für das "öffentliche" Netzwerk. Kann man da noch was in unraid aktivieren?

@mgutt genau die Nextcloud ist nur von außen erreichbar. Ich komme von innen nur drauf wenn ich die Dyndns-Adresse eingebe. Bin am überlegen eine weitere Nextcloud-Instanz aufzusetzen für mein internes Netzwerk (br0) aufzusetzen.

-

Hallo Zusammen,

ich habe mir überlegt, ob es nicht sinnvoller wäre, öffentliche Docker wie bspw. Nextcloud auf eine zweite Netzwerkkarte umzuleiten. Diese ist an einen separaten Port von meinem pfsense Router angeschlossen und ist vom internen Lan getrennt und geht direkt nach draußen.

Ich musste in meinem Router den Port 80 und 443 öffnen um swag und Nextcloud zu nutzen und diese Ports zielen direkt auf den unraid Server.

Mir wurde immer gesagt, dass man nach Möglichkeit keine Ports öffnen sollte aber für Nextcloud ist dies halt erforderlich.

Bisher habe ich mit "docker create network proxynet" ein Netzwerk erstellt und alle erforderlichen Dienste wie Nextcloud, swag und mariadb diesem Netzwerk zugeordnet. Wenn ich diese nun auf custom br1 umstelle bekomme ich Nextcloud nicht mehr zum laufen. Kann ich ein netzwerk erstellen, dass auf br1 leitet?

Ist mein Vorgehen überhaupt sinnvoll?

-

Thank you! It was the problem with the urbackup folder.

-

1

1

-

-

Hi JorgeB,

no in my opinion im not moving small files. Can i see anywhere, where the mover currently is and what he is moving?

Edit: Ok maybe im wrong. I have one folder where urbackup is backing up the Clients. There are a lot of files.

-

Hi,

i have a problem that my mover is very slow. Yesterday i installed a new unraid configuration and all files were transfered to the cache. Over night i hoped that the mover will put all files on the array. But since 1:30 pm he transferred only 106gb. I already restarted the server but it doesnt help. I have attached my diagnostic file.

-

Hi,

ich habe es hinbekommen. In der Fehlermeldung steht ja, dass er nicht die notwendigen Rechte hat auf die one-token.json zuzugreifen. Ich habe der Datei jetzt einfach mal alle möglichen Rechte gegeben und nun funktioniert es. Ich verstehe zwar nicht, warum er diese Rechte benötigt, weil diese Datei ja eigentlich nur die Authentifizierung zu meinem Onedrive Konto herstellt, aber Hauptsache es funktioniert :-)

@vakilando ja ich verwende 4 threats, so wie es vorgegeben wurde.

So viel gibt es ja bei duplicacy nicht einzustellen. Mache jetzt jede Nacht ein backup meiner wichtigsten Daten verschlüsselt zu onedrive. Er legt mir da jedesmal eine neue Revision an, hoffentlich läuft da nicht irgendwann etwas über :-)

-

Hallo,

ich habe mir Duplicacy als Docker installiert. Ich will damit meine wichtigsten Daten aus unraid verschlüsselt in onedrive sichern. Ich habe mir duplicacy auch gekauft. Beim synchronisieren bekomme ich irgendwann folgenden Fehler:

QuoteRunning backup command from /cache/localhost/0 to back up /backuproot Options: [-log backup -storage Backup -threads 4 -stats] 2022-09-17 22:27:08.394 INFO REPOSITORY_SET Repository set to /backuproot 2022-09-17 22:27:08.395 INFO STORAGE_SET Storage set to one://Backup 2022-09-17 22:27:13.419 INFO BACKUP_START No previous backup found 2022-09-17 22:27:13.419 INFO BACKUP_INDEXING Indexing /backuproot 2022-09-17 22:27:13.419 INFO SNAPSHOT_FILTER Parsing filter file /cache/localhost/0/.duplicacy/filters 2022-09-17 22:27:13.419 INFO SNAPSHOT_FILTER Loaded 0 include/exclude pattern(s) 2022-09-17 22:27:13.847 INFO INCOMPLETE_LOAD Incomplete snapshot loaded from /cache/localhost/0/.duplicacy/incomplete 2022-09-17 22:27:13.847 INFO BACKUP_LIST Listing all chunks 2022-09-17 22:28:56.866 INFO FILE_SKIP Skipped 1 files from previous incomplete backup 2022-09-17 22:28:56.868 INFO BACKUP_THREADS Use 4 uploading threads 2022-09-17 22:41:42.357 INFO ONEDRIVE_RETRY Response code: 500; retry after 557 milliseconds 2022-09-17 23:27:09.694 ERROR UPLOAD_CHUNK Failed to upload the chunk 4f494e94049f9107ca5cd70f0cea01bf5a36efb2ca23a62b4aee795255efd836: open /config/one-token.json: permission denied 2022-09-17 23:27:09.790 INFO INCOMPLETE_SAVE Incomplete snapshot saved to /cache/localhost/0/.duplicacy/incomplete Failed to upload the chunk 4f494e94049f9107ca5cd70f0cea01bf5a36efb2ca23a62b4aee795255efd836: open /config/one-token.json: permission denied

Kann mir da jemand weiterhelfen? Meine config im docker habe ich angehängt.

-

Quote

Du wirst das Array verlieren - ziemlich sicher. USB Verbindungen in einem RAID sind absolut fragile. Und wenn Dein Array unten ist, dann sind es Docker und KVM auch, denn zum Reparieren des Arrays musst Du das System stoppen müssen.

Ok überredet ich habe einen usb stick in den array gepackt und die hdd als unassigned device eingebunden.

QuoteWas nicht geht, weil du virtualisierst.

Nein tue ich aktuell nicht weil ich zfs native in unraid nutze auf der SSD.

QuoteDann benutz kein ZFS.

Dafür mag ich die Snapshot Funktion zu sehr die auch noch sauber in Windows mittels shadow copy genutzt werden kann.

Ich werde das jetzt ein paar Monate testen und falls Probleme auftreten, werde ich hier berichten. Ich denke das ist eine gute Lösung und bei mir ist es ausreichend wenn ich 1* die Woche die Daten dann auf ein Raidz2 Truenas System sichere und dann nochmal offsite. Muss nur schauen, wie ich das ganze noch automatisiert bekomme :-)

Vielen Dank!

-

Quote

Wird offiziell nicht unterstützt und ist dringend von abzuraten.

Leider habe ich aber keinen andere Anschlussmöglichkeit. Dort sind auch nur meine Surveillance Aufnahmen und paar andere unwichtige Daten drauf. Wenn ich die verliere stört mich das nicht.

QuoteNaja welchen Sinn hat es auch eine NAS Software innerhalb einer NAS Software zu virtualisieren. Nimm True NAS oder unRAID. Beides ist ziemlicher Nonsense.

Tja das Problem ist, dass unraid nicht so eine schöne Oberfläche für ZFS hat und man sich alles per Kommandozeile zusammen basteln muss. Andersrum hat unraid eine super gui was Docker und VMs betrifft. Ich möchte das beste aus beiden Welten und das möglichst energieeffzient :-)

QuoteAlso hast du Potential für 7 Tage Datenverlust. Kanst du damit leben oder nicht? Die Snapshots nützen dir ja Null bei SSD Defekt.

Ich nutze auch nur eine SSD, ich sichere jede Nacht aufs Array. Mein Potential also 24h. Kann ich mit leben.

Die Snapshots in unraid haben den Vorteil, dass meine Daten abgesichert sind von Ramsonware und ich bei kurzfristen Fehlern in Dokumenten auf eine vorherige Version springen kann. Ich könnte evtl. auch täglich ein Backup machen auf die 18TB USB Platte und so den Datenverlust auf 24h verringern. Zusätzlich werden ja wöchentlich Sicherungen auf Truenas gemacht. Diese Snapshots werden auch nie gelöscht. Meine Daten verändern sich in der Woche auch nicht großartig.

-

Hallo Zusammen,

ich bin aktuell hin und her gerissen wie ich mit meiner bestehenden Hardware am besten meine Server Konfiguration aufbauen soll. Ziel ist eine möglichst stromsparende Konfiguration.

Welche Hardware habe ich:

1. Clevo Laptop Hardware ohne Bildschirm. i7-8565U mit 24gb Ram

1* nvme Steckplatz

1* sata Anschluss

2. DellT30 mit 40gb DDR4 ECC Ram

3. HP ProLiant ML110 G7 mit 20gb DDR3 ECC Ram

Aktuell läuft bei mir 1. (unraid) mit einer 18TB Platte per USB angeschlossen im Array (24/7). In der nvme ist ein google coral und eine 1TB SSD an Sata als zfs für die wichtigen Daten, Docker und VMs. Läuft soweit alles prima. Der Stromverbrauch mit allen Dockern und VMs liegt hier im Schnitt bei 22W.

3. ist offsite und darauf läuft Truenas und damit wird 1x wöchentlich gestartet und alles wichtige von 1. gesichert.

Ich bin mir nur nicht sicher, ob es sicher genug ist die wichtigen Daten direkt auf die SSD von 1. ohne Raid zu schreiben. Leider hat der Clevo nicht genug Anschlüsse um noch eine 2te SSD anzuschließen und daraus ein zfs mirror zu erstellen. Darüber hinaus hat der Clevo auch kein ECC. Aber eigentlich wird alles 1* wöchentlich gesichert und per Snapshot versioniert.

Eine andere Möglichkeit wäre alles in 2. einzubauen und diesen 24/7 laufen zu lassen. Allerdings würde ich dort dann direkt zwei 4TB HDDs einbauen und eine Truenas VM in unraid und daraus ein mirror machen und dort meine wichtigen Daten sichern. Hier liegt der Verbrauch dann aber direkt bei 45 Watt.

Eigentlich reicht mir die Größe der 1TB SSD vorerst für meine wichtigsten Daten. Aber irgendwie hab ich ein mulmiges Gefühl wenn ich auf einer single SSD arbeite. Können sich da die Daten nicht verändern und korrupt werden. Mit einem raid wäre ich da wegen dem regelmäßigen Scrub sicherer unterwegs oder?

Wie würdet ihr das machen?

-

Hi,

im using zfs on unraid since a few months and it works great. I have a few questions. I use zfs-auto-snapshot.

1. Is it possible to do the snapshots for a specific dataset (rescursive) only?

2. Is there a command so that empty snapshots get deleted automatically?

3. I use truenas on another server offsite. Is it possible to send the snapshot to this truenas server so that they are also visible in the gui of truenas?

Thank you!

Kind regards,

Edgar

-

2 variants arrived and i think it will not work. They both have a realtek chipsat on it. Under Tools -> System devices i can not see anything about "Coral Edge TPU" anymore. There is only unde r usb devices:

Bus 001 Device 002:ID 0bda:9210 Realtek Semiconductor Corp. LM915

Im not nerdy enough to try a few terminal commands but i think if it does not recognize it as a Coral it will not work, or what is your opinion?

-

On 4/27/2022 at 9:17 AM, ich777 said:

Really curious if those adapters will work too...

i ordered 3 variants and will give you a feedback. I hope it will work *cross fingers* 🙂

-

2

2

-

-

Hi,

i have the coral b+m key. Do someone has an usb to m.2 adapter where the coral woks? I dont wont to lose an m.2 slot for the coral. But the usb and a+e variant is not available.

-

Ich kann dir frigate empfehlen. Das hat zwar leider keine schöne Gui für die Daueraufzeichnung, aber eine gute Objekterkennung. In Verbindung mit einem google coral, kann die Objektberechnung von der CPU auf den coral ausgelagert werden. Dadurch kann die CPU-Auslastung enorm gesenkt werden. Habe ich selber so auf meinem DellT30 im Einsatz und die CPU Aulastung ist in Verbindung mit 12 Kameras, 16 Docker und 1 centos VM bei ca. 50%.

-

11 hours ago, gyto6 said:

Yep, mount your docker.img into a ZVOL formated as your docker.img filesystem. Set your docker.img there (copy the old one in the new location) and you're good.

Create a script to mount the Zvol automatically at first "Start Array"Im sorry but im not able to do this. Do i have to create a dataset before i run your command? Or i do it with the first command already? Because i can not find docker under /mnt/ssdpool.

Which label type i have to use when i use the cfdisk command?

when i run the last command it says:

mount: /mnt/ssdpool/docker: mount point does not exist.

-

Hello,

i try to use ZFS because of the snapshot and shadow copy function. But i have the problem that i can not use docker on my single nvme zfs pool. I have created everything according to the first post but everytime i try to add a container it stands still and i can not restart the machine or stop the array. I have to hard reset the system. I use unraid 6.9.2. Following you can see a screenshot where it say's "Please wait" for a small docker like adguard for 1 hour now. 2 of 4 CPU cores are on 100% . Do you have an idea?

My Docker config:

-

Evtl. ist es noch folgender Hinweis sinnvoll. Wenn man auf dem Handy eine App wie bspw. den unraid Monitor installiert und sich als root angemeldet hat, ist man dauerhaft angemeldet und das Script wechselt nicht in den Lesemodus. Irgendwie logisch aber ich brauchte einiges an Zeit um das zu erkennen 🙂

-

20 hours ago, mgutt said:

Es gab einen Fehler im Skript, den ich nun behoben habe. Der Zeitstempel vom letzten Login wurde nicht korrekt aus den syslogs ausgelesen.

Funktioniert! Danke!

-

HI,

ich bekomme das Script irgednwie nicht zum laufen. Bei mir bleiben die Rechte auf read auch wenn ich mich per root im webinterface anmelde. Muss ich das Script einmal per "rund script" oder "run in Background" starten?

Komischerweise wenn ich auf rund script drücke steht da:

QuoteScript location: /tmp/user.scripts/tmpScripts/ransom_protection/script

Note that closing this window will abort the execution of this script

ls: cannot access '/var/log/syslog.[0-9]': No such file or directory

Last login was: Jan 6

[Media] Grant write permissions and set edgar to read-only

SMB config has not changedWarum setzt er den Share für den Nutzer den ich im share angegeben habe und der eigentlich temporär Schreibrechte bekommen habe auf "read-only" wenn ich im webinterface per root angemeldet bin und das Script manuell ausführe?

[Support] - Storj v3 docker

in Docker Containers

Posted

Luckely i havent deleted the old cache drive. I could restore my identity folder. Somehow he has not copied the key files. But i have copied them with cp * -r. I dont know why. But now it works 🙂