LyDjane

Members-

Posts

84 -

Joined

-

Last visited

Content Type

Profiles

Forums

Downloads

Store

Gallery

Bug Reports

Documentation

Landing

Everything posted by LyDjane

-

Zwei weitere Ordner mit "containerd" und "microsoft" schwankt immer zwischen 35% und 61%. Filesystem Size Used Avail Use% Mounted on rootfs 20G 777M 19G 4% / tmpfs 32M 2.8M 30M 9% /run /dev/sda1 30G 922M 29G 4% /boot overlay 20G 777M 19G 4% /lib overlay 20G 777M 19G 4% /usr devtmpfs 8.0M 0 8.0M 0% /dev tmpfs 20G 0 20G 0% /dev/shm tmpfs 384M 15M 370M 4% /var/log /dev/md1p1 7.3T 3.4T 4.0T 47% /mnt/disk1 /dev/nvme0n1p1 932G 93G 838G 10% /mnt/cache shfs 7.3T 3.4T 4.0T 47% /mnt/user0 shfs 7.3T 3.4T 4.0T 47% /mnt/user /dev/loop2 100G 19G 78G 19% /var/lib/docker

-

Bei mir schaut es tatsächlich so aus: 12M /bin 921M /boot 0 /dev 15M /etc 0 /home 0 /hugetlbfs 0 /init 0 /lib 36M /lib64 0 /mnt 184M /opt 532K /portainer 0 /proc 24K /root 2.8M /run 23M /sbin 0 /sys 35M /tmp 0 /usr 474M /var

-

Server hat sich beruhigt und wieder normale Auslastung. Bisher läuft alles tadellos.

-

Guten Morgen zusammen, Update wurde gefahren. Einstellungen sind derzeit folgendermaßen: Settings > Network Settings > eth0 > Enable Bonding = Yes Settings > Network Settings > eth0 > Enable Bridging = No Settings > Docker > Host access to custom networks = Enabled Das sollte dann doch genau so bei mir im Fall funktionieren, oder? Vielen Dank und euch ein schönes Wochenende!

-

Mit der neuen Version ist der Fehler vermutlich immer noch vorhanden oder?

-

So habe es ich es auch verstanden 🙂 Schade.

-

Wow... 😐 Danke @alturismo

-

kurze Frage. Ist das Problem in der 6.12.3 immer noch vorhanden?

-

Hey Ich konnte problemlos auf die 11.5 zurück, da mir diese als wiederherstellen in der gui angezeigt wurde. Bisher sind die Probleme auch nicht mehr vorhanden und es läuft stabil alles.

-

Guten Morgen zusammen, vielen Dank für deine ausführliche Antwort. Ich bin auf die 6.11.5 zurück. da der Server heute Nacht wieder abgestürzt ist. Den localhost habe ich nun eingetragen und die logs werden geschrieben 🤗 ich dachte, ich könnte damit untersuchen, was nachts passiert. Aber es schadet nicht, dass ich diese nun nachvollziehen kann. Vielen vielen Dank!!

-

Übrigends ist die 6.12.1 raus.

-

Kann ich denn einfach wieder zur Version 6.11 zurück ohne probleme? Frage bzgl dem systemprotokoll-server ist noch weiter vorhanden

-

Yes. br0 aktiv und macvlan ist aktiv. Fritzbox ist im Einsatz

-

Guten Morgen zusammen, letzte Woche Samstag habe ich das Update auf 6.12 gemacht. Der Server lief davor tadellos und ohne Probleme. Seitdem Update ist er nachts bereits 3 mal innerhalb von 7 Tagen "eingefroren?". Die Logs konnte ich nicht schauen, da diese nicht mehr abgreifbar waren (die GUI war nicht mehr aufrufbar). Damit ich die Logs nun bei erneutem Problem auswerten kann, habe ich eine Freigabe "logs" erstellt. Ich habe jetzt die folgende Einstellungen in dem Systemprotokoll-Server gesetzt: Es werden allerdings stand gerade keine Logs geschrieben? Muss noch etwas anderes aktiviert werden? Viele Grüße und vielen Dank!!!

-

hey, how did you do that? I am facing the same problem.

-

dann bitte Vorsicht. Auf / für einen VPS bist Du als Admin verantwortlich. Wie stellst Du sicher, dass das OS / der VPS entsprechend gegen Attacken abgesichert ist? da bin ich schmerzfrei. Mehr als eine Umwandlung von der IPv4 auf die öffentliche IPv6 passiert damit derzeit nicht. Updates fahre ich natürlich dann. Hast du eine Empfehlung für ein Image? OPNsense 22.7 (amd64) - OPNsense-22.7-OpenSSL-dvd-amd64.iso pfSense CE 2.6.0 (amd64) - pfSense-CE-2.6.0-RELEASE-amd64.iso stehen beide unter anderem zur Verfügung. Ich würde gerne so wenig Konfigurationsaufwand wie möglich mit dem VPS haben. Vielen Dank und viele Grüße!

-

okay, das übersteigt meine Kenntnisse um ein vielfaches. ich habe 6tunnel via Console dort installiert und war happy, dass es läuft. Mal eben eine VM darauf installieren, das wird glaube ich so nichts bei mir. Oder kann ich via Docker dort wireguard installieren?

-

Hallo in die Runde und vielen vielen Dank schon einmal für die Infos! Ich habe via Deutsche Glasfaser nur eine öffentliche IPv6 und eine nicht öffentliche IPv4. Business Upgrade ist für mich sinnfrei, da ich aus Kostengründen zu Deutsche Glasfaser gewechselt habe von der Telekom. Natürlich wäre mein Favorit, dass es via FritzBox wieder funktioniert (es funktioniert von IPv6 aus auch problemlos). Ich habe seit Mittwoch letzte Woche einen VPS mit 6tunnel am laufen, sodass die Dienste auch via IPv4 im Netzwerk erreichbar sind. Es hängt gerade tatsächlich alles nur noch an Wireguard, da ich auch nicht weis, ob man in der Fritzbox Wireguard noch anders konfigurieren muss etc. Da bin ich als Laie raus. Ich habe die "einfache" Einstellung dort verwendet. Wenn man natürlich wireguard dort so konfigurieren kann, dass es auch über den VPS läuft, wäre das natürlich der Wahnsinn

-

Hallo in die Runde, ich komme nicht weiter und melde mich daher mal bei euch, vielleicht habe ich einfach einen großen Denkfehler oder eine Denkblockade. Ich habe bis vor kurzem problemlos mein Wireguard über die Fritzbox genutzt. Seitdem ich nun aber seit Sonntag von der Telekom (es lief alles via IPv4) auf die Glasfaser (nun alles via IPv6) umgestiegen bin, komme ich von reinen IPv4 Netzwerken nicht mehr via mein Wireguard ins Netzwerk..... Jetzt dachte ich mir, nachdem ich mein NGINX und DynDNS schon komplett ummodeln durfte, setzte ich einen eigenen Wireguard Docker Container auf. Docker läuft soweit auch, allerdings komme ich einfach nicht ins Netzwerk rein.... Port 51820 UDP ist in der Fritzbox freigegeben, jedoch bin ich mir auch total unschlüssig ob ich diesen auf den NGINX (Docker hat eine eigene IP) oder auf den unRAID-Server freigegeben muss. Verzweifelt wie ich bin, habe ich schon beides probiert, erfolglos. Kann mir hier jemand weiterhelfen? Viele Grüße

-

Same problem here influxdb is crashed all the time. I was already a little worried. With the latest docker image it runs stable and problem-free. Thanks!

-

genau so in etwa schalte den host access aus und der 2. Eintrag (shim bridge) ist inaktiv. Bedeutet aber auch, dass die Docker die als "host" laufen, dann nicht mehr funktionieren?

-

Einstellungen sind bei mir exakt genau so. Heißt die zweite "IP" ist der Docker Host access dann an der Stelle? Danke!!

-

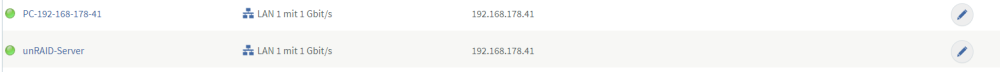

Sorry für die späte Rückmeldung, ich war selbst sehr lange noch auf der Suche nach dem Fehler, aber bin mit meinem Latein am Ende. Folgendes habe ich herausfinden können in der Zwischenzeit: mein ESET meldet regelmäßig, dass im Netzwerk eine IP-Adresse doppelt vergeben ist. die doppelte IP-Adresse stammt anscheinend vom unRAID-Server (Screenshot aus der Frizbox) der unRAID-Server selbst hat in den Netzwerkeinstellungen die MAC-Adresse XYZ, diese stimmt auch mit der in der Fritzbox unter unRAID-Server überein. die IP-Adresse .41 (also die zweite) hat allerdings eine völlig andere MAC-Adresse, die ich nicht zuordnen kann. Ich bin alle Docker durchgegangen, welche auf dem unRAID-Server laufen und habe die MAC Adressen kontrolliert, es ist kein Docker. Ich habe zur Vorsicht auch alle Docker deaktiviert und dann die Fritzbox neu gestartet, ohne einen laufenden Docker war die doppelte IP-Adresse trotzdem wieder vorhanden. In der Fritzbox ist der unRAID-Server als statisch mit der .41 hinterlegt. In den unRAID Einstellungen als "automatisch". Die zweite .41 IP-Adresse kann ich auch nicht auf eine andere ändern in der Fritzbox. Viele Grüße

-

Guten Morgen zusammen, ich hatte in der Vergangenheit immer mal wieder Probleme, dass nach dem Start des PC ich nicht auf die Freigaben gekommen bin (welche im PC eingebunden sind) und auch unRAID sowie meine Docker nicht via Webbrowser aufrufen konnte. Weiterhin konnte ich den Server auch nicht via ping erreichen. Es gab immer die Fehlermeldung "Zeitüberschreitung". Nachdem ich den PC neu starte oder einfach eine Zeit X gewartet habe, funktionierte es plötzlich wieder problemlos. Heute habe ich an einem Docker gearbeitet und wurde plötzlich wieder "ausgesperrt". Sowohl mit dem Handy als auch mit dem Tablet erreiche ich alles problemlos. Folgendes habe ich nun in den Logs entdeckt: Oct 7 10:22:50 unRAID-Server avahi-daemon[13014]: New relevant interface veth77cad04.IPv6 for mDNS. Oct 7 10:22:50 unRAID-Server avahi-daemon[13014]: Registering new address record for XXXX::XXXX:XXXX:feb2:864c on veth77cad04.*. Oct 7 10:23:54 unRAID-Server vsftpd[29474]: connect from XXX.XXX.XXX.49 (XXX.XXX.XXX.49) Oct 7 10:23:54 unRAID-Server vsftpd[29474]: [root] OK LOGIN: Client "XXX.XXX.XXX.49" Oct 7 10:24:20 unRAID-Server kernel: veth64c6cd8: renamed from eth0 Oct 7 10:24:20 unRAID-Server kernel: docker0: port 10(veth77cad04) entered disabled state Oct 7 10:24:20 unRAID-Server avahi-daemon[13014]: Interface veth77cad04.IPv6 no longer relevant for mDNS. Oct 7 10:24:20 unRAID-Server avahi-daemon[13014]: Leaving mDNS multicast group on interface veth77cad04.IPv6 with address XXXX::XXXX:XXXX:feb2:864c. Oct 7 10:24:20 unRAID-Server kernel: docker0: port 10(veth77cad04) entered disabled state Oct 7 10:24:20 unRAID-Server kernel: device veth77cad04 left promiscuous mode Oct 7 10:24:20 unRAID-Server kernel: docker0: port 10(veth77cad04) entered disabled state Oct 7 10:24:20 unRAID-Server avahi-daemon[13014]: Withdrawing address record for XXXX::XXXX:XXXX:feb2:864c on veth77cad04. Oct 7 10:24:28 unRAID-Server kernel: docker0: port 10(vetha188847) entered blocking state Oct 7 10:24:28 unRAID-Server kernel: docker0: port 10(vetha188847) entered disabled state Oct 7 10:24:28 unRAID-Server kernel: device vetha188847 entered promiscuous mode Oct 7 10:24:28 unRAID-Server kernel: docker0: port 10(vetha188847) entered blocking state Oct 7 10:24:28 unRAID-Server kernel: docker0: port 10(vetha188847) entered forwarding state Oct 7 10:24:28 unRAID-Server kernel: docker0: port 10(vetha188847) entered disabled state Oct 7 10:24:29 unRAID-Server kernel: eth0: renamed from veth90b18bf Oct 7 10:24:29 unRAID-Server kernel: IPv6: ADDRCONF(NETDEV_CHANGE): vetha188847: link becomes ready Oct 7 10:24:29 unRAID-Server kernel: docker0: port 10(vetha188847) entered blocking state Oct 7 10:24:29 unRAID-Server kernel: docker0: port 10(vetha188847) entered forwarding state Oct 7 10:24:31 unRAID-Server avahi-daemon[13014]: Joining mDNS multicast group on interface vetha188847.IPv6 with address XXXX::XXXX:XXX:fef1:e898. Oct 7 10:24:31 unRAID-Server avahi-daemon[13014]: New relevant interface vetha188847.IPv6 for mDNS. Oct 7 10:24:31 unRAID-Server avahi-daemon[13014]: Registering new address record for XXXX::XXXX:XXX:fef1:e898 on vetha188847.*. Oct 7 10:26:03 unRAID-Server kernel: docker0: port 10(vetha188847) entered disabled state Oct 7 10:26:03 unRAID-Server kernel: veth90b18bf: renamed from eth0 Oct 7 10:26:03 unRAID-Server avahi-daemon[13014]: Interface vetha188847.IPv6 no longer relevant for mDNS. Oct 7 10:26:03 unRAID-Server avahi-daemon[13014]: Leaving mDNS multicast group on interface vetha188847.IPv6 with address XXXX::XXXX:XXX:fef1:e898. Oct 7 10:26:03 unRAID-Server kernel: docker0: port 10(vetha188847) entered disabled state Oct 7 10:26:03 unRAID-Server kernel: device vetha188847 left promiscuous mode Oct 7 10:26:03 unRAID-Server kernel: docker0: port 10(vetha188847) entered disabled state Oct 7 10:26:03 unRAID-Server avahi-daemon[13014]: Withdrawing address record for XXXX::XXXX:XXX:fef1:e898 on vetha188847. Oct 7 10:26:03 unRAID-Server kernel: docker0: port 10(veth2984986) entered blocking state Oct 7 10:26:03 unRAID-Server kernel: docker0: port 10(veth2984986) entered disabled state Oct 7 10:26:03 unRAID-Server kernel: device veth2984986 entered promiscuous mode Oct 7 10:26:03 unRAID-Server kernel: docker0: port 10(veth2984986) entered blocking state Oct 7 10:26:03 unRAID-Server kernel: docker0: port 10(veth2984986) entered forwarding state Oct 7 10:26:03 unRAID-Server kernel: eth0: renamed from veth6ea744c Oct 7 10:26:03 unRAID-Server kernel: IPv6: ADDRCONF(NETDEV_CHANGE): veth2984986: link becomes ready Oct 7 10:26:05 unRAID-Server avahi-daemon[13014]: Joining mDNS multicast group on interface veth2984986.IPv6 with address XXXX::XXXX:XXXX:XXXX:d0c8. Oct 7 10:26:05 unRAID-Server avahi-daemon[13014]: New relevant interface veth2984986.IPv6 for mDNS. Oct 7 10:26:05 unRAID-Server avahi-daemon[13014]: Registering new address record for XXXX::XXXX:XXXX:XXXX:d0c8 on veth2984986.*. Oct 7 10:26:34 unRAID-Server kernel: veth6ea744c: renamed from eth0 Oct 7 10:26:34 unRAID-Server kernel: docker0: port 10(veth2984986) entered disabled state Oct 7 10:26:34 unRAID-Server avahi-daemon[13014]: Interface veth2984986.IPv6 no longer relevant for mDNS. Oct 7 10:26:34 unRAID-Server avahi-daemon[13014]: Leaving mDNS multicast group on interface veth2984986.IPv6 with address XXXX::XXXX:XXXX:XXXX:d0c8. Oct 7 10:26:34 unRAID-Server kernel: docker0: port 10(veth2984986) entered disabled state Oct 7 10:26:34 unRAID-Server kernel: device veth2984986 left promiscuous mode Oct 7 10:26:34 unRAID-Server kernel: docker0: port 10(veth2984986) entered disabled state Oct 7 10:26:34 unRAID-Server avahi-daemon[13014]: Withdrawing address record for XXXX::XXXX:XXXX:XXXX:d0c8 on veth2984986. Oct 7 10:26:34 unRAID-Server kernel: docker0: port 10(vethcbac438) entered blocking state Oct 7 10:26:34 unRAID-Server kernel: docker0: port 10(vethcbac438) entered disabled state Oct 7 10:26:34 unRAID-Server kernel: device vethcbac438 entered promiscuous mode Oct 7 10:26:34 unRAID-Server kernel: docker0: port 10(vethcbac438) entered blocking state Oct 7 10:26:34 unRAID-Server kernel: docker0: port 10(vethcbac438) entered forwarding state Oct 7 10:26:34 unRAID-Server kernel: eth0: renamed from vethf54458d unter Port 10 vom Docker läuft Heimdall (https://hub.docker.com/r/linuxserver/heimdall). Entsteht der Fehler durch diesen Docker? Und wenn ja wieso sperrt er mich aus? Die IP von meinem PC ist immer die gleiche, wieso klappt es nach einem Neustart sofort problemlos? Viele Grüße und vielen Dank vorab!