-

Posts

66 -

Joined

-

Last visited

Content Type

Profiles

Forums

Downloads

Store

Gallery

Bug Reports

Documentation

Landing

Posts posted by frah

-

-

1 hour ago, hawihoney said:

Das macht man doch über das Path-Mapping - also über den Docker Weg

Du hast natürlich vollkommen Recht! So habe ich es in den Einstellungen des Containers auch vorgenommen:

Hatte mich zunächst im Schlagwort "verweist" von mgutt verlaufen und einen Symlink angelegt meinen Fehler jedoch später bemerkt und revidiert. Habe die Korrektur nur nicht in meinem Betrag vermerkt :-/

15 hours ago, mgutt said:Korrekt wäre es, wenn der eine paperless Unterordner auf einen Unraid Share verweist und eben nicht unterhalb von appdata liegt.

-

12 hours ago, mgutt said:

Korrekt wäre es, wenn der eine paperless Unterordner auf einen Unraid Share verweist und eben nicht unterhalb von appdata liegt.

Danke für den Hinweis. Habe den Fehler, so hoffe ich, wie folgt korrigiert:

- Share "dms-scans" eingerichtet (unRAID Array)

- /mnt/cache/appdata/paperless/consume gelöscht

- Symlink für das consume-Verzeichnis von paperless angelegt (ln -s /mnt/user/dms-scans /mnt/cache/appdata/paperless-ngx/consume)

- den unRAID Benutzer, der für den Scanner genutzt wird, mit den notwendingen SMB-Rechten auf "dms-scans" versehen

-

1 hour ago, Ford Prefect said:

Edit: mal die Berechtigungen im Unterordner geprüft? Diese werden von paperless-ng angelegt und gesetzt nicht von unraid.

Edited 1 hour ago by Ford Prefect

Das ist die Lösung, nachdem ich das "consume" Unterverzeichnis mit den passenden Rechten ausgestattet habe funktioniert der Zugriff. Danke für den Wink mit dem Zaunpfahl.

40 minutes ago, DataCollector said:Falls Du es nicht hinbekommst, vielleicht als Umgehungslösung ein Script, welches alle xx Minuten nachsieht ob neue Dateien dort aufgetaucht sind und diese dann in das ... consume Verzeichnis verschiebt.

So hatte ich es bisher gelöst.

-

Hallo zusammen,

für meine Freigaben verwende ich normalerweise ausschließlich NFS Shares doch mein Dokumentenscanner erlaubt lediglich Zugriff über SMB Freigaben.

Aus diesem Grund habe ich folgendes konfiguriert:

- SMB Dienst aktiviert/gestartet

- lokalen Benutzer "DMS" samt Kennwort via Web-UI angelegt

- Share "appdata" via SMB freigegeben

- Benutzer DMS mit Schreib-/Leserechten auf das Share "appdata" ausgestattet

Hinterlege ich nun in meinem Scanner ein Profile, dass Zugriff auf "\\unRAID-Server-IP\appdata" hat wird diese Einstellung vom Scanner aktzeptiert. Doch Ziel ist es die dem Scanner Zugriff auf \\unRAID-Server-IP\appdata\paperless-ngx\consume" zu geben, was leider nicht akzeptiert wird.

Meiner Logik nach sollte dies doch funktionieren, da "\paperless-ngx\consume" ein Unterverzeichnis der Freigabe "appdata" ist.?!?

Freigaben von Unterverzeichnissen sind, wenn ich das richtig sehe, in unRAID nicht möglich. Also arbeite ich derzeit mit einem Userscript, dass vom Scanner abgelegte Daten in das richtige Verzeichnis verschiebt.

Wo habe ich bezüglich der SMB Freigabe einen Denkfehler?

Gruß,

Frank

-

11 hours ago, frah said:

But on Linux (Arch) clients using `vdirsyncer discover` I'm facing the following issue:

Both systems Android smartphones (DAVx5) and Linux hosts (vdirsyncer) are working now. The solution was quite simple, all I did was changing the authentication type from "Digest" to "Basic".

-

1

1

-

-

Today if installed the Baikal Docker container on my unRAID server created users, calendars and addressbooks. Connecting to the server and sync Cal-/CardDAV data works like a charm using Android phones w/ DAVx5:

## ---- ## unRAID version ## ---- 6.11.5 ## ---- ## Docker image on unRAID ## ---- REPOSITORY TAG IMAGE ID CREATED ckulka/baikal nginx bded0d70eae9 2 months ago ## ---- ## Baikal Docker logs using DAVx5 (v4.3) ## ---- 172.17.0.1 - [email protected] [04/Mar/2023:17:56:36 +0100] "PROPFIND /dav.php/principals/[email protected]/ HTTP/1.1" 401 441 "-" "DAVx5/4.3-ose (2023/02/11; dav4jvm; okhttp/4.10.0) Android/10" "188.126.165.38, 172.18.0.1" 172.17.0.1 - - [04/Mar/2023:17:56:36 +0100] "PROPFIND /dav.php/principals/[email protected]/ HTTP/1.1" 207 564 "-" "DAVx5/4.3-ose (2023/02/11; dav4jvm; okhttp/4.10.0) Android/10" "188.126.165.38, 172.18.0.1" 172.17.0.1 - - [04/Mar/2023:17:56:36 +0100] "PROPFIND /dav.php/addressbooks/[email protected]/ HTTP/1.1" 207 2769 "-" "DAVx5/4.3-ose (2023/02/11; dav4jvm; okhttp/4.10.0) Android/10" "188.126.165.38, 172.18.0.1" But on Linux (Arch) clients using `vdirsyncer discover` I'm facing the following issue: ## ---- ## Baikal Docker logs using vdirsyncer (v0.19.1) ## ---- 172.17.0.1 - [email protected] [04/Mar/2023:17:59:22 +0100] "PROPFIND /dav.php/addressbooks/[email protected]/contacts/ HTTP/1.1" 401 455 "-" "vdirsyncer/0.19.1" "188.126.165.38, 172.18.0.1" 172.17.0.1 - [email protected] [04/Mar/2023:17:59:22 +0100] "PROPFIND /dav.php/addressbooks/[email protected]/contacts/ HTTP/1.1" 401 455 "-" "vdirsyncer/0.19.1" "188.126.165.38, 172.18.0.1" 172.17.0.1 - [email protected] [04/Mar/2023:17:59:22 +0100] "PROPFIND /.well-known/carddav HTTP/1.1" 302 145 "-" "vdirsyncer/0.19.1" "188.126.165.38, 172.18.0.1" 172.17.0.1 - - [04/Mar/2023:17:59:23 +0100] "PROPFIND /dav.php HTTP/1.1" 401 415 "-" "vdirsyncer/0.19.1" "188.126.165.38, 172.18.0.1" 172.17.0.1 - [email protected] [04/Mar/2023:17:59:23 +0100] "PROPFIND /dav.php/addressbooks/[email protected]/contacts/ HTTP/1.1" 401 455 "-" "vdirsyncer/0.19.1" "188.126.165.38, 172.18.0.1" 172.17.0.1 - [email protected] [04/Mar/2023:17:59:23 +0100] "PROPFIND /dav.php/addressbooks/[email protected]/contacts/ HTTP/1.1" 401 455 "-" "vdirsyncer/0.19.1" "188.126.165.38, 172.18.0.1" 172.17.0.1 - [email protected] [04/Mar/2023:17:59:23 +0100] "PROPFIND /.well-known/carddav HTTP/1.1" 302 145 "-" "vdirsyncer/0.19.1" "188.126.165.38, 172.18.0.1" 172.17.0.1 - - [04/Mar/2023:17:59:23 +0100] "PROPFIND /dav.php HTTP/1.1" 401 415 "-" "vdirsyncer/0.19.1" "188.126.165.38, 172.18.0.1" ## ---- ## Output of `vdirsyncer -v DEBUG discover` ## ---- vdirsyncer -v DEBUG discover debug: Fetching value for username.fetch with command strategy. debug: Fetching value for password.fetch with command strategy. Discovering collections for pair contacts contacts_local: debug: ==================== debug: PROPFIND https://dav.rndsvc.com/dav.php/addressbooks/[email protected]/contacts/ debug: {'User-Agent': 'vdirsyncer/0.19.1', 'Content-Type': 'application/xml; charset=UTF-8', 'Depth': '1'} debug: b'\n <propfind xmlns="DAV:">\n <prop>\n <resourcetype />\n </prop>\n </propfind>\n ' debug: Sending request... debug: 401 debug: <CIMultiDictProxy('Date': 'Sat, 04 Mar 2023 17:00:36 GMT', 'Content-Type': 'application/xml; charset=utf-8', 'Content-Length': '443', 'Connection': 'keep-alive', 'Cache-Control': 'no-store, no-cache, must-revalidate', 'Dav': '1, 3, extended-mkcol, access-control, calendarserver-principal-property-search, calendar-access, calendar-proxy, calendar-auto-schedule, calendar-availability, resource-sharing, calendarserver-sharing, addressbook', 'Expires': 'Thu, 19 Nov 1981 08:52:00 GMT', 'Pragma': 'no-cache', 'Set-Cookie': 'PHPSESSID=evids5r7svcashgnsmg1i5cpov; path=/; HttpOnly', 'Strict-Transport-Security': 'max-age=63072000;includeSubDomains; preload', 'Vary': 'Brief,Prefer', 'WWW-Authenticate': 'Digest realm="BaikalDAV",qop="auth",nonce="640379340bd30",opaque="d66d5f0524036afcb61420e358f990ce"', 'X-Sabre-Version': '4.3.1', 'CF-Cache-Status': 'DYNAMIC', 'Report-To': '{"endpoints":[{"url":"https:\\/\\/a.nel.cloudflare.com\\/report\\/v3?s=EvVbjwpq5DS%2Bhih4yYdulFl0zSkSnMxM5RAoenrb4Y72gcI5VXQXNuj3Q8oLxGg7cFf4i%2FCBte%2BD9UgZ5dAAdVx6efOXysDhoWlU2RRJhf9tDVB09TQvDoFnb%2BdJ4v6fjA%3D%3D"}],"group":"cf-nel","max_age":604800}', 'NEL': '{"success_fraction":0,"report_to":"cf-nel","max_age":604800}', 'Server': 'cloudflare', 'CF-RAY': '7a2bad251df4c4b8-DUS', 'alt-svc': 'h3=":443"; ma=86400, h3-29=":443"; ma=86400')> debug: <StreamReader 443 bytes eof> debug: Given URL is not a homeset URL debug: ==================== debug: PROPFIND https://dav.rndsvc.com/dav.php/addressbooks/[email protected]/contacts/ debug: {'User-Agent': 'vdirsyncer/0.19.1', 'Content-Type': 'application/xml; charset=UTF-8', 'Depth': '0'} debug: b'\n <propfind xmlns="DAV:">\n <prop>\n <current-user-principal />\n </prop>\n </propfind>\n ' debug: Sending request... debug: 401 debug: <CIMultiDictProxy('Date': 'Sat, 04 Mar 2023 17:00:36 GMT', 'Content-Type': 'application/xml; charset=utf-8', 'Content-Length': '443', 'Connection': 'keep-alive', 'Cache-Control': 'no-store, no-cache, must-revalidate', 'Dav': '1, 3, extended-mkcol, access-control, calendarserver-principal-property-search, calendar-access, calendar-proxy, calendar-auto-schedule, calendar-availability, resource-sharing, calendarserver-sharing, addressbook', 'Expires': 'Thu, 19 Nov 1981 08:52:00 GMT', 'Pragma': 'no-cache', 'Set-Cookie': 'PHPSESSID=nog46rblrk9s1gb9oqnlcpg7vl; path=/; HttpOnly', 'Strict-Transport-Security': 'max-age=63072000;includeSubDomains; preload', 'Vary': 'Brief,Prefer', 'WWW-Authenticate': 'Digest realm="BaikalDAV",qop="auth",nonce="640379341513d",opaque="d66d5f0524036afcb61420e358f990ce"', 'X-Sabre-Version': '4.3.1', 'CF-Cache-Status': 'DYNAMIC', 'Report-To': '{"endpoints":[{"url":"https:\\/\\/a.nel.cloudflare.com\\/report\\/v3?s=LlZ7FVvpTxR%2Fa%2FuqmndcY0ivUgKFISa%2BJziwrSXOCvmMzmfEssZ0NbaYBwQG2q38upYMF9yHH6KzrqOO4G2pCTO%2Fenf%2BXayP1hD0qKr0GDWawa2yBj03%2BOz14PRtC96mlg%3D%3D"}],"group":"cf-nel","max_age":604800}', 'NEL': '{"success_fraction":0,"report_to":"cf-nel","max_age":604800}', 'Server': 'cloudflare', 'CF-RAY': '7a2bad256e19c4b8-DUS', 'alt-svc': 'h3=":443"; ma=86400, h3-29=":443"; ma=86400')> debug: <StreamReader 443 bytes eof> debug: Trying out well-known URI debug: ==================== debug: PROPFIND https://dav.rndsvc.com/.well-known/carddav debug: {'User-Agent': 'vdirsyncer/0.19.1', 'Content-Type': 'application/xml; charset=UTF-8', 'Depth': '0'} debug: b'\n <propfind xmlns="DAV:">\n <prop>\n <current-user-principal />\n </prop>\n </propfind>\n ' debug: Sending request... debug: 401 debug: <CIMultiDictProxy('Date': 'Sat, 04 Mar 2023 17:00:36 GMT', 'Content-Type': 'application/xml; charset=utf-8', 'Content-Length': '403', 'Connection': 'keep-alive', 'Cache-Control': 'no-store, no-cache, must-revalidate', 'Dav': '1, 3, extended-mkcol, access-control, calendarserver-principal-property-search, calendar-access, calendar-proxy, calendar-auto-schedule, calendar-availability, resource-sharing, calendarserver-sharing, addressbook', 'Expires': 'Thu, 19 Nov 1981 08:52:00 GMT', 'Pragma': 'no-cache', 'Set-Cookie': 'PHPSESSID=ggdrpobcs8b2rlekqhc9l9uefg; path=/; HttpOnly', 'Strict-Transport-Security': 'max-age=63072000;includeSubDomains; preload', 'Vary': 'Brief,Prefer', 'WWW-Authenticate': 'Digest realm="BaikalDAV",qop="auth",nonce="640379342aa0d",opaque="d66d5f0524036afcb61420e358f990ce"', 'X-Sabre-Version': '4.3.1', 'CF-Cache-Status': 'DYNAMIC', 'Report-To': '{"endpoints":[{"url":"https:\\/\\/a.nel.cloudflare.com\\/report\\/v3?s=72yai8YD9uUcR%2BN4MQV5efPaA%2BAB6Cv9c6cyiJHFtvYTkH5g%2F%2BynwqDGL%2BAjxMYT2edvkS2guCRoiud1yYsstPwZxHRio99WJjFHYSun5XBeJtJDjhLkEBlCEt0ArveIvg%3D%3D"}],"group":"cf-nel","max_age":604800}', 'NEL': '{"success_fraction":0,"report_to":"cf-nel","max_age":604800}', 'Server': 'cloudflare', 'CF-RAY': '7a2bad25fe6ac4b8-DUS', 'alt-svc': 'h3=":443"; ma=86400, h3-29=":443"; ma=86400')> debug: <StreamReader 403 bytes eof> debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/cli/discover.py", line 263, in _print_collections debug: discovered = await get_discovered() debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/cli/discover.py", line 176, in get_self debug: self._discovered = await self._discover() debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/cli/discover.py", line 185, in _discover debug: return handle_storage_init_error(self._cls, self._config) debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/cli/discover.py", line 181, in _discover debug: discovered = await aiostream.stream.list(self._cls.discover(**self._config)) debug: File "/usr/lib/python3.10/site-packages/aiostream/core.py", line 33, in wait_stream debug: async for item in streamer: debug: File "/usr/lib/python3.10/site-packages/aiostream/stream/aggregate.py", line 71, in list debug: async for item in streamer: debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/storage/dav.py", line 488, in discover debug: async for collection in d.discover(): debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/storage/dav.py", line 274, in discover debug: for c in await self.find_collections(): debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/storage/dav.py", line 235, in find_collections debug: self._find_collections_impl(await self.find_home()) debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/storage/dav.py", line 209, in find_home debug: url = await self.find_principal() debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/storage/dav.py", line 174, in find_principal debug: return await self._find_principal_impl(self._well_known_uri) debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/storage/dav.py", line 187, in _find_principal_impl debug: response = await self.session.request( debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/storage/dav.py", line 416, in request debug: return await http.request(method, url, session=session, **more) debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/http.py", line 153, in request debug: response.raise_for_status() debug: File "/usr/lib/python3.10/site-packages/aiohttp/client_reqrep.py", line 1005, in raise_for_status debug: raise ClientResponseError( warning: Failed to discover collections for contacts_remote, use `-vdebug` to see the full traceback. debug: ==================== debug: PROPFIND https://dav.rndsvc.com/dav.php/addressbooks/[email protected]/contacts/ debug: {'User-Agent': 'vdirsyncer/0.19.1', 'Content-Type': 'application/xml; charset=UTF-8', 'Depth': '1'} debug: b'\n <propfind xmlns="DAV:">\n <prop>\n <resourcetype />\n </prop>\n </propfind>\n ' debug: Sending request... debug: 401 debug: <CIMultiDictProxy('Date': 'Sat, 04 Mar 2023 17:00:36 GMT', 'Content-Type': 'application/xml; charset=utf-8', 'Content-Length': '443', 'Connection': 'keep-alive', 'Cache-Control': 'no-store, no-cache, must-revalidate', 'Dav': '1, 3, extended-mkcol, access-control, calendarserver-principal-property-search, calendar-access, calendar-proxy, calendar-auto-schedule, calendar-availability, resource-sharing, calendarserver-sharing, addressbook', 'Expires': 'Thu, 19 Nov 1981 08:52:00 GMT', 'Pragma': 'no-cache', 'Set-Cookie': 'PHPSESSID=u5803gh9na83hv273q8h21scsr; path=/; HttpOnly', 'Strict-Transport-Security': 'max-age=63072000;includeSubDomains; preload', 'Vary': 'Brief,Prefer', 'WWW-Authenticate': 'Digest realm="BaikalDAV",qop="auth",nonce="6403793436d7d",opaque="d66d5f0524036afcb61420e358f990ce"', 'X-Sabre-Version': '4.3.1', 'CF-Cache-Status': 'DYNAMIC', 'Report-To': '{"endpoints":[{"url":"https:\\/\\/a.nel.cloudflare.com\\/report\\/v3?s=mCLub0M2vbCDQcDJaiqHU0adtfhBDGVjqb8sqC0Fk5BXcQOej%2F8ctAm6EPprFCWfr5OMccD9%2F4sYqf6NWTrSOXR8BuMwULMaGuerQO%2B%2FtyWb3vPydAp5syxIOAWSrn75sA%3D%3D"}],"group":"cf-nel","max_age":604800}', 'NEL': '{"success_fraction":0,"report_to":"cf-nel","max_age":604800}', 'Server': 'cloudflare', 'CF-RAY': '7a2bad263e94c4b8-DUS', 'alt-svc': 'h3=":443"; ma=86400, h3-29=":443"; ma=86400')> debug: <StreamReader 443 bytes eof> debug: Given URL is not a homeset URL debug: ==================== debug: PROPFIND https://dav.rndsvc.com/dav.php/addressbooks/[email protected]/contacts/ debug: {'User-Agent': 'vdirsyncer/0.19.1', 'Content-Type': 'application/xml; charset=UTF-8', 'Depth': '0'} debug: b'\n <propfind xmlns="DAV:">\n <prop>\n <current-user-principal />\n </prop>\n </propfind>\n ' debug: Sending request... debug: 401 debug: <CIMultiDictProxy('Date': 'Sat, 04 Mar 2023 17:00:36 GMT', 'Content-Type': 'application/xml; charset=utf-8', 'Content-Length': '443', 'Connection': 'keep-alive', 'Cache-Control': 'no-store, no-cache, must-revalidate', 'Dav': '1, 3, extended-mkcol, access-control, calendarserver-principal-property-search, calendar-access, calendar-proxy, calendar-auto-schedule, calendar-availability, resource-sharing, calendarserver-sharing, addressbook', 'Expires': 'Thu, 19 Nov 1981 08:52:00 GMT', 'Pragma': 'no-cache', 'Set-Cookie': 'PHPSESSID=bs0eg9r9d3innqmqe1bktnvo1k; path=/; HttpOnly', 'Strict-Transport-Security': 'max-age=63072000;includeSubDomains; preload', 'Vary': 'Brief,Prefer', 'WWW-Authenticate': 'Digest realm="BaikalDAV",qop="auth",nonce="640379343ff6d",opaque="d66d5f0524036afcb61420e358f990ce"', 'X-Sabre-Version': '4.3.1', 'CF-Cache-Status': 'DYNAMIC', 'Report-To': '{"endpoints":[{"url":"https:\\/\\/a.nel.cloudflare.com\\/report\\/v3?s=lzyYn2ujcadD0Vqh4RwRrkhkuX8uZOn%2FYADuGNogeHVmVDVPGME%2FSGdwjvvQma5hMp3dQ0S4X2rA1xiHLHMru0NAl8vSb%2BT%2B6L%2F5NznlbffB0PmjtaYpOaI2LlPgDasRRg%3D%3D"}],"group":"cf-nel","max_age":604800}', 'NEL': '{"success_fraction":0,"report_to":"cf-nel","max_age":604800}', 'Server': 'cloudflare', 'CF-RAY': '7a2bad268ecbc4b8-DUS', 'alt-svc': 'h3=":443"; ma=86400, h3-29=":443"; ma=86400')> debug: <StreamReader 443 bytes eof> debug: Trying out well-known URI debug: ==================== debug: PROPFIND https://dav.rndsvc.com/.well-known/carddav debug: {'User-Agent': 'vdirsyncer/0.19.1', 'Content-Type': 'application/xml; charset=UTF-8', 'Depth': '0'} debug: b'\n <propfind xmlns="DAV:">\n <prop>\n <current-user-principal />\n </prop>\n </propfind>\n ' debug: Sending request... debug: 401 debug: <CIMultiDictProxy('Date': 'Sat, 04 Mar 2023 17:00:36 GMT', 'Content-Type': 'application/xml; charset=utf-8', 'Content-Length': '403', 'Connection': 'keep-alive', 'Cache-Control': 'no-store, no-cache, must-revalidate', 'Dav': '1, 3, extended-mkcol, access-control, calendarserver-principal-property-search, calendar-access, calendar-proxy, calendar-auto-schedule, calendar-availability, resource-sharing, calendarserver-sharing, addressbook', 'Expires': 'Thu, 19 Nov 1981 08:52:00 GMT', 'Pragma': 'no-cache', 'Set-Cookie': 'PHPSESSID=fbcimoaevdlftek837dtarl1oe; path=/; HttpOnly', 'Strict-Transport-Security': 'max-age=63072000;includeSubDomains; preload', 'Vary': 'Brief,Prefer', 'WWW-Authenticate': 'Digest realm="BaikalDAV",qop="auth",nonce="6403793453e19",opaque="d66d5f0524036afcb61420e358f990ce"', 'X-Sabre-Version': '4.3.1', 'CF-Cache-Status': 'DYNAMIC', 'Report-To': '{"endpoints":[{"url":"https:\\/\\/a.nel.cloudflare.com\\/report\\/v3?s=OoDib5JKLWmDb0m%2FxOO99DmvAh7M%2FrMHFl0k5nExt8PyiF5hR12QzG7BiGJsu4SdOxnKckIod1CJVJEgI9CxHR2JH7VedqvRj%2BIqJA4W%2FLou1Qt4oZtjrOQbOn58gNLA0Q%3D%3D"}],"group":"cf-nel","max_age":604800}', 'NEL': '{"success_fraction":0,"report_to":"cf-nel","max_age":604800}', 'Server': 'cloudflare', 'CF-RAY': '7a2bad270f06c4b8-DUS', 'alt-svc': 'h3=":443"; ma=86400, h3-29=":443"; ma=86400')> debug: <StreamReader 403 bytes eof> error: Unknown error occurred: 401, message='Unauthorized', url=URL('https://dav.rndsvc.com/dav.php') error: Use `-vdebug` to see the full traceback. debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/cli/__init__.py", line 32, in inner debug: f(*a, **kw) debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/cli/__init__.py", line 221, in discover debug: asyncio.run(main()) debug: File "/usr/lib/python3.10/asyncio/runners.py", line 44, in run debug: return loop.run_until_complete(main) debug: File "/usr/lib/python3.10/asyncio/base_events.py", line 649, in run_until_complete debug: return future.result() debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/cli/__init__.py", line 213, in main debug: await discover_collections( debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/cli/tasks.py", line 92, in discover_collections debug: rv = await collections_for_pair(pair=pair, **kwargs) debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/cli/discover.py", line 97, in collections_for_pair debug: rv = await aiostream.stream.list( debug: File "/usr/lib/python3.10/site-packages/aiostream/core.py", line 33, in wait_stream debug: async for item in streamer: debug: File "/usr/lib/python3.10/site-packages/aiostream/stream/aggregate.py", line 71, in list debug: async for item in streamer: debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/cli/discover.py", line 212, in expand_collections debug: collections = await get_b_discovered() debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/cli/discover.py", line 176, in get_self debug: self._discovered = await self._discover() debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/cli/discover.py", line 185, in _discover debug: return handle_storage_init_error(self._cls, self._config) debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/cli/discover.py", line 181, in _discover debug: discovered = await aiostream.stream.list(self._cls.discover(**self._config)) debug: File "/usr/lib/python3.10/site-packages/aiostream/core.py", line 33, in wait_stream debug: async for item in streamer: debug: File "/usr/lib/python3.10/site-packages/aiostream/stream/aggregate.py", line 71, in list debug: async for item in streamer: debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/storage/dav.py", line 488, in discover debug: async for collection in d.discover(): debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/storage/dav.py", line 274, in discover debug: for c in await self.find_collections(): debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/storage/dav.py", line 235, in find_collections debug: self._find_collections_impl(await self.find_home()) debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/storage/dav.py", line 209, in find_home debug: url = await self.find_principal() debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/storage/dav.py", line 174, in find_principal debug: return await self._find_principal_impl(self._well_known_uri) debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/storage/dav.py", line 187, in _find_principal_impl debug: response = await self.session.request( debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/storage/dav.py", line 416, in request debug: return await http.request(method, url, session=session, **more) debug: File "/usr/lib/python3.10/site-packages/vdirsyncer/http.py", line 153, in request debug: response.raise_for_status() debug: File "/usr/lib/python3.10/site-packages/aiohttp/client_reqrep.py", line 1005, in raise_for_status debug: raise ClientResponseError(

If further information is needed I am happy to provide it. -

Rack und leise sind problemlos realisierbar, siehe meine Signatur. Jedes der beiden System befindet sich in einem Büro (eines, bkpbitch, bei meinen Eltern und das andere, binvault, bei mir).

Sämtliche Werkslüfter, mit Ausnahme die der Netzteile, wurde gegen Noctua-Lüfter getauscht.

-

On 11/19/2022 at 1:47 AM, mgutt said:

BTRFS ist ziemlich sensibel was Servercrash und Stromausfall anbelangt. Auch gibt es immer wieder mal Setups, wo die NVMe wohl nicht schnell genug aus dem Standby hoch kommt oder was weiß ich. Auf jeden Fall gibt es mehr Ärger mit BTRFS als mit XFS.

Wie handhabst Du den Einsatz von Cache Datenträgern, @mgutt. Gegenwärtig nutze ich zwei NVMes im BTRFS RAID1 Verbund. Grund ist, dass ich den Cache erst bei 75% Füllstand mittels Mover auf das Array verschieben lasse um einen möglichst langen spin down der HDDs zu realisieren.

Was ich mir alternativ vorstellen könnte wäre nur eine NVMe, die als Cache-Laufwerk (XFS Dateisystem) genutzt wird und den Inhalt alle X Minuten/Stunden mittels rsync auf die zweite NVMe (ebenfalls XFS Dateisystem) zu kopieren.

-

Wie wäre es mit Syncthing?! Eine Instanz auf dem unRAID Host und die andere innerhab von Xpenology.

-

Ich gehe mal davon aus, dass Du den Free Account von Cloudflare nutzt. Somit stellt die Nutzung von Streaming einen Verstoß gegen S2.8 der TOS dar.

-

1

1

-

-

Bezüglich der von dir genannten Optionen kann ich dir leider nicht weiterhelfen möchte dir aber noch eine dritte Möglichkeit aufzeigen, die ich für meine Backup-Jobs nutze. @mgutt hat sich die Mühe gemacht ein Script für rsync Backups zu erstellen, dass auch stetig erweitert/verbessert wird:

-

1

1

-

-

44 minutes ago, fiR3W4LL said:

Ich habe noch 2xX570D4U-2L2T vorhanden, ich könnte dies kurz nachschauen solange die noch da sind

werden bei nächster Gelegenheit verkauft.

werden bei nächster Gelegenheit verkauft.

Das ist nett von dir, doch werden Bitfurcation Infos bzgl. des X570D4U (ohne 10G Onboard NICs) benötigt. Hatte das X570D4U kurze Zeit mal in meiem unRAID Server doch bin ich mir bzgl. der möglichen Optionen nicht mehr sicher.

Was auf jeden Fall möglich war ist das Splitting zu x4x4x4x4 und x8x8, ob weitere Einstellungen zur Verfügung standen kann ich nicht mehr mit Sicherheit sagen.

-

18 hours ago, mgutt said:

Heh? Slot 7 gibt es doch gar nicht. Das Board hat die Slots 4, 5 und 6.

Hast natürlich Recht! Mein Hirn hat den Suffix "-2L2T" vollkommen ausgeblendet. Bezogen auf das zuvor gepostete Bild ging es um das X570D4U-2L2T. Habe das Mainboard nicht mehr um nachschauen zu können.

-

24 minutes ago, mgutt said:

Ne ich meinte das AMD Board oder hast du das nicht mehr?

Bei dem konnte man den x16 Port auf x8x4x4 oder x4x4x4x4 einstellen, wenn ich mich richtig erinnere.

Mal schnell die Suchmaschine meines Vertrauens befragt und folgendes Ergebnis erhalten:

-

ä

13 hours ago, mgutt said:2x M.2 gingen, 8x SATA und dann wäre die Frage wie man die Lanes der PCIe Ports aufteilen kann. Wenn X8 + X4X4 geht, könnte man in den ersten Slot eine T600 stecken und in den zweiten eine Dual M.2 Karte ( @frah was für Einstellungen gibt es im BIOS?) Also falls du auf 4 NVMe gehen willst. Ansonsten eben eine ASM1166 SATA Karte oder mit Dual M.2 Karte und 2x ASM1166 M.2 SATA Karten, gingen sogar insgesamt 20 SATA Buchsen.

Im BIOS des C246M-WU4 lässt sich bzgl. Bitfucation lediglich x8x8 einstellen. Somit könnte man eine vierfach NVMe PCIe Karte im x16 Slot platzieren und zwei der vier M.2 NVMe Anschlüsse verwenden. Hatte diesbezüglich auch Kontakt mit dem Gigabyte Support und folgende Antwort erhalten:

QuoteDieses MB ist nicht x8/x4/x4 oder x4/x4/x4/x4 auf dem PCIe x16 Steckplatz geroutet, sondern nur x8/x8. Das hat nichts mit dem BIOS zu tun.

-

2 hours ago, primeval_god said:

You do need to have the http:// portion of the address as well as the the IP and port numbers of your server. Also the [IP]:[PORT] syntax of dockerman will not work in the compose plugin.

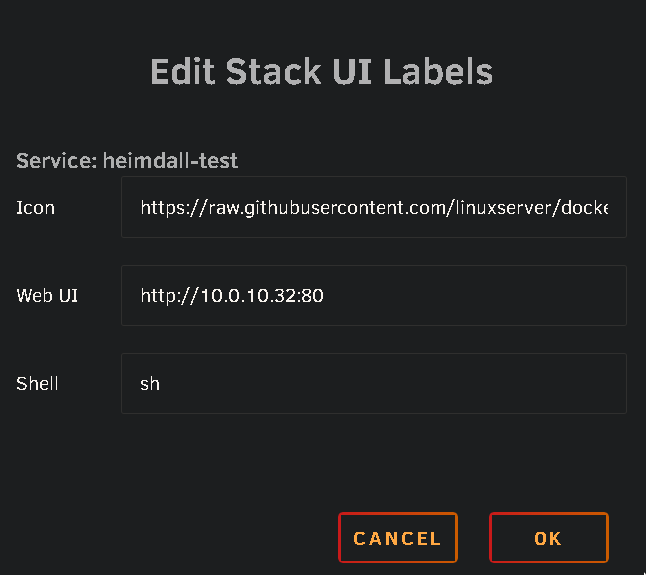

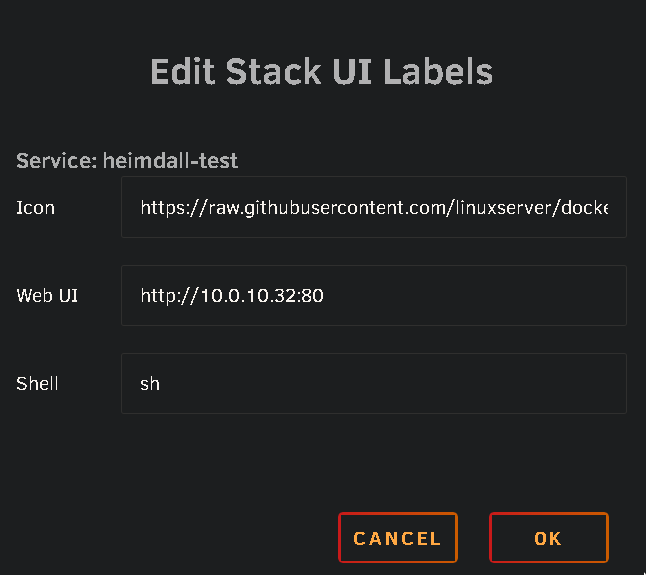

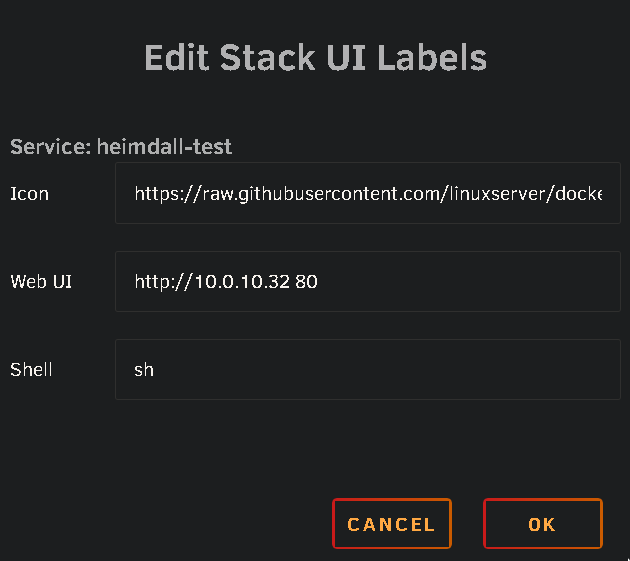

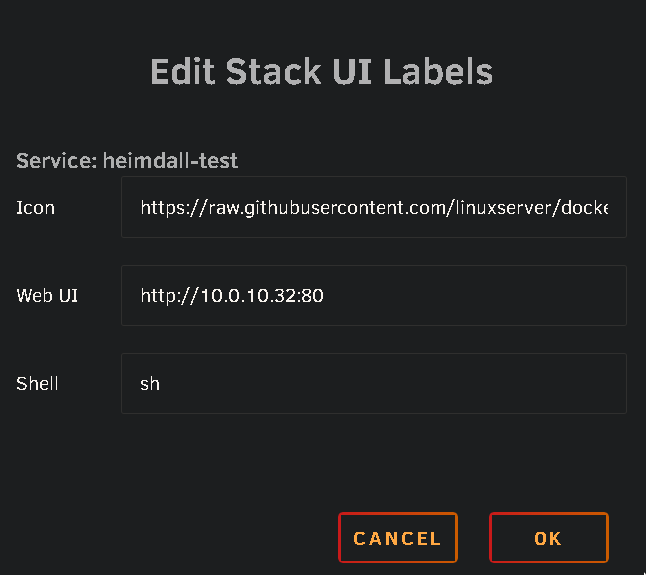

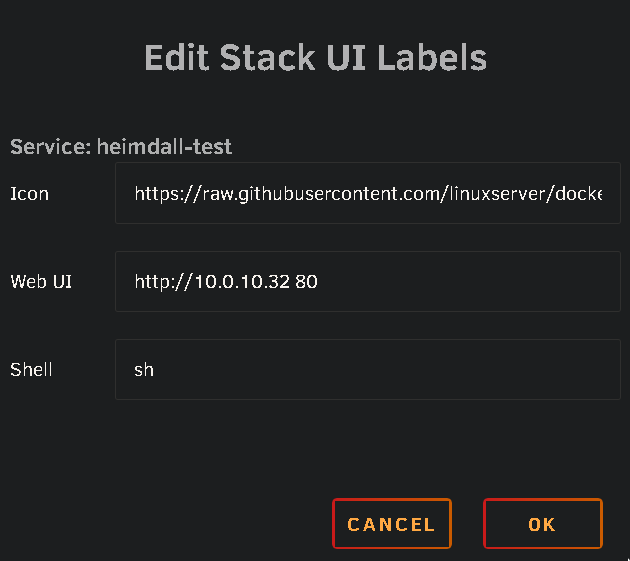

Thanks for your reply @primeval_god if I enter http://10.0.10.32:80 or http://10.0.10.32 80 the WebUI button opens a new tab with the URL http://10.0.10.32/10.0.10.32:80.

-

On 10/7/2022 at 6:18 PM, swallace said:

Did prepending "http;//" really solve this problem?

I'm currently tinkering with Docker Compose Manager and encountering the same problem regardless of what I type in the web UI field. I have already tried things like:

http://[IP]:[PORT:1234]

http://[IP]:[PORT]

[IP]:[PORT:1234]

12.34.56.78:1234

:[PORT]

:1234

[PORT]

1234Clicking on the web UI button takes me to:

http://<unRAID-server-IP>/<unRAID-server-IP>:<host-port-of-container> -

-

Guten Morgen liebe Community, kennt jemand eine Möglichkeit hier im Forum nach Beiträgen zu suchen, die von einem bestimmten Mitglied erstellt wurden?

Ich möchte mir z. B. gerne alle von @mgutt initial erstellten Beiträge auflisten lassen, also ohne bei der Suche Rücksicht auf Antworten durch besagte(n) Benutzer zu nehmen.

Eine Suche nach Benutzernamen liefert ja sämtliche Forenaktivitäten und geht am Ziel vorbei.

Gesendet von meinem PH-1 mit Tapatalk

-

Also ich bin mit einem AMD System (ASRock Rack X570D4U mit Ryzen 5600X) gestartet: idle Verbrauch war ~26 Watt. Kurze Zeit später habe ich die Hardware getauscht (Gigabyte C246M mit i3-9100); 12,5 Watt idle. Siehe dazu meinen Beitrag.

Docker habe ich inzwischen folgende aktiv: Authentic, Cloudflared, MariaDB, Redis, FileRun, Vaultwarden, Nginx Proxy Manager, Bookstack, Syncthing und Heimdall.

Der i3-9100 ist noch recht gelangweilt und die RAM-Auslastung (32GB) liegt bei ca. 10%.

Mit den von dir aufgeführten VMs wir wird sich dies auch nicht kritisch darstellen. Ggf. ist HomeAssisant auch als Docker Container anstelle einer VM interessant, Ressourcen würde es auf jeden Fall einsparen.

Amazon bietet hin und wieder kleine Stückzahlen des Gigabyte C246M-WU4 an und, sofern nicht noch in der Schublade, ein i3-(8/9)xxx ist leicht via eBay (Kleinanzeigen) zu beschaffen.

Sollte die CPU mal dauerhaft außer Atem kommen, bietet sich mit dem C246M-WU4 die Möglichkeit diese gegen einen Xeon E-2xxx zu tauschen. Die Freude am System, ohne es gleich komplett zu ersetzen, bleibt also langfristig gegeben.

-

1

1

-

-

Der PCIe x16 Slot unterstützt x8/x8 Bitfucation @Minion

-

Every now and then you can find it at Amazon, @huascar77

-

Reumütig bin ich wieder zurück ins Intel-Lager geschlichen, da mir der Sinn doch nach etwas noch sparsameren stand/steht und entschied auf, durch die Community bereits ausgiebig erprobte, Hardware zu setzen.

Hans im Glück

Großes Glück hatte ich bei der Hardwarebeschaffung, denn Amazon UK hatte noch ein paar (drei) Gigabyte C246M-WU4-Motherboards (157,23 €/Stück) auf Lager von denen ich gleich zwei für meine unRAID Systeme (Haupt- und Backup-Server) bestellte. Die restliche Hardware, mit Ausnahme eines Gehäuses und eines Netzteils, war bereits vorhanden.

Inspiriert durch die Server-Vorstellung von @MartinG wurde ein Fractal Design Define R5 gekauft, dass in meinem 19" Rack sein neues Zuhause findet und die Hardware des Haupt-Servers beherbergt. Die Stromversorgung wird durch ein, von @mgutt empfohlenes, Corsair RM550x (2021) sichergestellt, das ich bei eBay günstig (Neuware) erstehen konnte.

Jetzt fehlte nur noch eine weitere unRAID Lizenz, da der von mir bisher verwendete Backup-Server mit einer Testlizenz lief. Dank eines Beitrags von @cz13 konnte ich diese mit einem Rabatt von 20% erwerben. Damit der Server mit seiner, aufgrund der Lizenz, stolz geschwellten Brust ausreichen Platz hat zieht er in das Gehäuse (SC743AC) des bisherigen unRAID Servers.

Watt steht auf der Uhr?

Die folgenden Messungen wurde ca. 20 Minuten nach dem Booten mit schlafenden Platten und zuvor ausgeführtem powertop --auto-tune durchgeführt:

AMD System: ASRock Rack X570D4U, Ryzen 5600X, 2x 32GB DDR4 ECC, 3x WD40EFRX, 2x Corsair MP600 R2 1TB, Supermicro SC743AC, bq Straight Power 11 Platinum 550W: 26 Watt

Intel System #1 (binvault): Gigabyte C246M-WU4, i3-9100, 1x 32GB DDR4 ECC, 3x WD40EFRX, 2x Corsair MP600 R2 1TB, Fractal Design Define R5, Corsair RM550x: 12,5 Watt

Intel-System #2 (bkpbitch): Gigabyte C246M-WU4, Celeron G4930T, 4x 16GB DDR4 ECC, 4x WD201KRYZ, Supermicro SC743AC, bq Straight Power 11 Platinum 550W: 11,8 Watt

Der Host binvault dient primär als Fileserver zur Bereitstellung von Dokumenten, Bildern, Audio und Video im LAN. Weiterhin wird er als Docker-Host für Nginx Proxy Manager, Cloudflare DDNS, Nextcloud, MariaDB, Bookstack, AdGuard-Home (derzeit in der Testphase), Syncthing und Heimdall genutzt

Damit alle Client-Systeme sowie der Server binvault täglich gesichert werden können bietet der Host bkpbitch seine Dienste als rsync Backupziel an und wird via WOL aus dem Traumland geholt; tägliche Betriebszeit ca. zwei Stunden.

Blick in die Kristallkugel, oder nach dem Umbau ist vor dem Umbau

Mögliche Upgrades/Umbauten von binvault:

- HDDs mit mehr Kapazität, um mit dem Kapazitätsbedarf Schritt zu halten

- CPU-Upgrade auf Xeon E-2xxxG, falls VMs mal zur Diskussion stehen sollten

- weitere M.2 NVMe Laufwerke via AOC-SLG3-2M2-O (liegt im Schrank) für VMs

Mögliche Upgrades/Umbauten von bkpbitch:

- Zusätzliche Festplatten, um das stetig wachsende Datenvolumen zu bewältigen

- Sollte binvault ein CPU-Upgrade erhalten zieht der i3-9100 um zu bkpbitch

-

4

4

-

Ggf. hilft dir der folgende, externe, Beitrag weiter @sonic6. Habe beides bisher nicht im Einsatz, denke jedoch ernsthaft darüber nach.

Ups, URL vergessen...

https://fictionbecomesfact.com/homeassistant-container

Gesendet von meinem PH-1 mit Tapatalk

Direktzugriff auf Unterverzeichnis einer SMB Freigabe

in Deutsch

Posted

@Hiko0 Verwende unRAID/Docker nicht länger, da ich zu Proxmox gewechselt bin, kann also leider nicht mehr nachsehen. Dem Scanner-User hatte ich Schreibrechte auf das betreffende Share zugeteilt und in den Einstellungen des Scanners halt ganz normal die Information bzgl. des Shares auf dem unRAID Server - die

Richtigkeit dieser Information kannst Du im gleichen Dialog des Scanner Webinterface validieren lassen.

Mit der neuen Umgebung (Proxmox) lasse ich alle gescannten Daten in einem separaten NFS/Samba LXC ablegen. Auf diesem habe ich einen Cronjob eingerichtet, der das entprechende Verzeichnis auf neue Dokumente überprüft und diese dann in das consume Verzeichnis meines Paperless-ngx LXC verschiebt.