-

Posts

3497 -

Joined

-

Last visited

-

Days Won

7

Content Type

Profiles

Forums

Downloads

Store

Gallery

Bug Reports

Documentation

Landing

Everything posted by hawihoney

-

One-Drives und/oder Google-Drives & Co benutzen als Backup-Ort

hawihoney replied to Mehlzoerwer's topic in Deutsch

Duplicati kenne ich nicht, nutze ich nicht. rclone kenne ich, nutze ich. Hat für mich den Vorteil auf Wunsch als mount und share nahtlos in Unraid verankert zu sein. Es gibt bestimmt eine Trillion Backup Mechanismen. Ich habe einen aufgeführt. Da hat jeder seine eigenen Präferenzen. -

Austausch einer Festplatte, mit gerningerer Kapazität

hawihoney replied to Torben_TSL's topic in Deutsch

Ja. Ich empfehle das Kapitel zum Unraid Array und der Parity im Manual. Danach dürfte das klar werden. Eine mit Unbalance leer gemachte Platte ist aus Unraid Sicht nicht leer. Nur eine komplett mit 0 gefüllte Platte ist richtig leer und kann entfernt werden. Das komplette Füllen mit 0 muss aber auch in der Parity vermerkt werden damit die Verfügbarkeit jederzeit gewährleistet ist. Daher 14 Schritte. https://docs.unraid.net/legacy/FAQ/Parity/ -

Austausch einer Festplatte, mit gerningerer Kapazität

hawihoney replied to Torben_TSL's topic in Deutsch

Ja, so funktioniert das nicht in einem Array mit Parity ohne die Ausfallsicherheit zu verlieren. Das Problem ist halt der Austausch durch eine kleinere Platte. Nimm halt eine gleich große Platte dann ist es tatsächlich "alte Platte raus, neue Platte rein, Unraid machen lassen". Das Entfernen einer Platte aus einem Array mit Parity umfasst 14 Schritte. Nur so ist die Ausfallsicherheit jederzeit garantiert. Kannst das natürlich alles in den Wind schießen und den "New Config" Weg gehen. Das ist dann aber Deine Entscheidung bzw. Dein möglicher Datenverlust. Der Vollständigkeit halber die Schritte zum Entfernen einer Platte aus einem Array mit Parity unter Beibehaltung der Ausfallsicherheit. Danach bist Du kuriert und kaufst eine gleich große Platte https://docs.unraid.net/unraid-os/manual/storage-management/#removing-disks -

One-Drives und/oder Google-Drives & Co benutzen als Backup-Ort

hawihoney replied to Mehlzoerwer's topic in Deutsch

rclone kann das. Such mal hier im Forum. Es gibt diverse Threads zu rclone. Auch im deutschen Forum. -

Austausch einer Festplatte, mit gerningerer Kapazität

hawihoney replied to Torben_TSL's topic in Deutsch

Es gibt sogar ein Manual: https://docs.unraid.net/unraid-os/manual/storage-management/#replacing-disks -

FTP ist ein ganz einfaches Protokoll, so wie auch z.B. Usenet, Mail, etc. Als die entstanden musste ich die noch auf der Kommandozeile abrufen. Da ich davor schon ein paar Jahre einen BBS (Bulletin Board System) für andere Entwickler betrieben hatte, war das pillepalle einfach. Ich schweife ab ... FTP und seine Derivate gehören nicht nach draußen PUNKT. Alternativen gibt es reichlich. Für so eine simple Bildbetrachtung würde ich persönlich kein Fass (NGINX, diverse Container, Router Ports) aufmachen. Ich würde mir einen ohnehin sinnvollen VPN Kanal ins Netzwerk schaffen (z.B. über den Router). Dann kannst Du Dir die Bilder völlig banal über den Dynamix File Manager (Plugin aus dem Unraid App Store) anschauen. Wenn Du doch mehr willst vielleicht dann doch Nextcloud oder oder oder. Wenn Du z.B. eine Fritzbox besitzt starte mit deren VPN (Stichwort MyFritz) und probiere den Zugriff auf die Bilder aus. Komplizieren kann man dann immer noch ...

-

Vorne, lokal, anfangen: Parent Custom=user und Child Custom=ipcam. Existiert der User annke in Unraid? Was passiert bei dieser Einstellung? ftp://username:password@IpDesServers Du landest mit FTP unter /mnt/ deshalb Custom Parent=user. Danach folgt der Share. War ganz einfach zu testen. Wenn das läuft gehts ans externe betrachten.

-

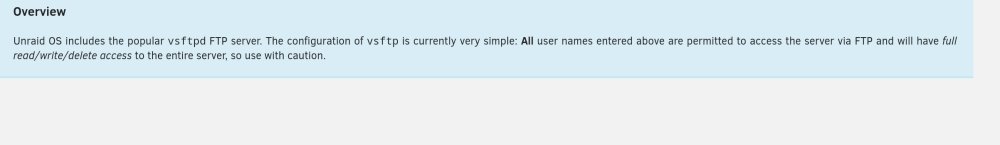

Es gibt ein Problem mit 6.12.9 unter ganz bestimmten Umständen. Wer diese Konfiguration betreibt sollte 6.12.9 noch nicht installieren. Es geht um CIFS/SMB Remote Mounts die mit Unassigned Devices in Unraid angelegt werden (/mnt/remotes/xxx). Das heißt Unraid ist der Klient einer CIFS/SMB Verbindung. Die Funktion von Unraid als Server einer CIFS/SMB Verbindung ist nach derzeitigem Erkenntnisstand davon nicht betroffen. Es gibt zwei aktuelle Bug Reports, einer ist von mir: Weiterhin gibt es von @dlandon einen Hinweis wohin das Problem zeigt (Kernel/SAMBA): Erkennen könnt Ihr das Problem eindeutig an den CIFS VFS Fehlern in der syslog. Wenn diese auftauchen, dann seht Ihr oder Eure Software nur einen Teil der existierenden Ordner oder Dateien. Das kann erhebliche Probleme nach sich ziehen. Wer 6.12.9 über 6.12.8 bereits installiert hat, und diese Konfiguration betreibt bzw. den Fehler bekommt --> ein Downgrade auf 6.12.8 ist jederzeit problemlos möglich:

- 1 reply

-

- 7

-

-

-

[6.12.9] CIFS: VFS: directory entry name would overflow frame end of buf

hawihoney commented on unCoreX's report in Stable Releases

As I wrote - client mounts thru Unassigned Devices only AFAIK. Server/NAS shares work as usual AFAIK. The problem shows up if Unraid is the SMB client - not the server. -

[6.12.9] CIFS: VFS: directory entry name would overflow frame end of buf

hawihoney commented on unCoreX's report in Stable Releases

I don't rate that as a "major" regression. If you don't use remote SMB/CIFS mounts you won't even notice it. It's a little niggle IMHO. Something that appears in special circumstances. -

Versuch doch erstmal das Ganze ans Laufen zu bringen - nicht immer weitere Störfeuer. Hast Du meine beiden Anmerkungen oben umgesetzt?

-

[6.12.9] CIFS: VFS: directory entry name would overflow frame end of buf

hawihoney commented on unCoreX's report in Stable Releases

Just downgrade - no need to change config etc: -

[6.12.9] CIFS: VFS: directory entry name would overflow frame end of buf

hawihoney commented on unCoreX's report in Stable Releases

In my case these were Unraid Servers running 6.12.9 as well. I did upgrade them all yesterday. All have SMB mounts to each others disks (disk shares) via Unassigned Devices. They all showed this error. The mounts were there, but showed only the first directory per mount. syslog was full of CIFS VFS errors. After downgrading all machines to 6.12.8 business is back as usual. -

Versuch doch mal Custom "user" unter Parent Directory und Camera Name unter Child Directory. Hier treffen zwei dämliche Systeme aufeinander.

-

[6.12.9] Since update UD always shows just one folder - the first one

hawihoney commented on hawihoney's report in Stable Releases

I'm quiet sure that this is releated to this bug linked below. syslog shows system errors, the result is Unassigned Devices not working properly IMHO. -

[6.12.9] CIFS: VFS: directory entry name would overflow frame end of buf

hawihoney commented on unCoreX's report in Stable Releases

Did post diagnostics in my bug report: -

[6.12.9] CIFS: VFS: directory entry name would overflow frame end of buf

hawihoney commented on unCoreX's report in Stable Releases

Confirmed. Back to 6.12.8 as well. -

This morning I did update from 6.12.8 to 6.12.9. Everything looked good BUT my remote shares from Unassigned Devices don't work any longer. I use this to start my remote shares: /usr/local/sbin/rc.unassigned mount //192.168.178.101/disk1 Looking at the result it says "Success". But looking at the directories I see the first folder only. Looking at syslog it shows lots of: Tower kernel: CIFS: VFS: directory entry name would overflow frame end of buf 000000001ffe5d91 I think there's something broken between 6.12.8 and 6.12.9. Will go back soon. Diagnostics attached. tower-diagnostics-20240327-1537.zip

-

Ich sach doch, das verwirrt total. Ziel Lokal /mnt/user/Test_LB/ readonly Quelle Remote ssh root@host:/mnt/user/Test/ Der kann am Ziel nicht schreiben. Nachtrag: Ändere /mnt/user/ auf read/write und schmeiß diesen überflüssigen Pfad aus den Container-Einstellungen:

-

Damit wir das richtig verstehen. Host: /mnt/user/Test/ <--> im Container: /mnt/user/Test/ Remote Host: /mnt/remotes/<Servername>/Test/ <--> im Container: /mnt/user/Test/ Wie heißen die voll qualifizierten Ordner? Und welcher Ordner läßt sich wo nicht löschen? Mir fehlt da Einiges an Details.

-

Für eines der kommenden Release wird erwartet, dass die Grenzen fallen werden. Wenn ich das im Interview mit dem Inhaber richtig gehört habe, dann wird das Array zu einem Pool. Und man wird dann mehrere Array-Pools anlegen können. In diesem Zuge fallen dann auch die Grenzen des Movers. Pool zu Pool wird dann möglich sein. Wie gesagt: Das wurde im Interview angedeutet.

-

Das geht nicht ohne Eingriff des Herstellers. Es wird zwar nie erwähnt, aber die Lizenz ist nicht nur an den Stick sondern auch an die E-Mail Adresse gebunden. Wende Dich an den LimeTech Support und schildere Deine Situation. Halte Kaufnachweise o.ä. bereit. Die werden die Lizenz auf die neue E-Mail transferieren und der alten E-Mail den Zugang entfernen: https://unraid.net/contact

-

Aber die hast Du eben nicht - und mich hat das bereits verwirrt. /mnt/user/user/... oder /mnt/user/remotes/... ? Würde ich nie so machen. Wenn schon dann: /mnt/addons/ --> /mnt/addons/ /mnt/disks/ --> /mnt/disks/ /mnt/remotes/ --> /mnt/remotes/ /mnt/user/ --> /mnt/user/ Dann könntest Du wie selbstverständlich z.B. von /mnt/user/Dokumente/ nach /mnt/remotes/Backup/Dokumente/ oder vice versa sichern und es würde bei Host und Container mit identischen Pfaden gearbeitet. Alles andere wird auf Dauer verwirren. Aber wie schon von Euch gesagt: Das ist Latte, kann jeder machen wie er will. Oder für die, die wissen was sie machen, und vielleicht faul sind: /mnt/ --> /mnt/

-

Hab zwar selber keine User Shares im Einsatz, aber sind die remotes tatsächlich auch unter /mnt/user/ zu finden? Dann würde bei mir /mnt/user (FUSE) über drei Rechner laufen. Das kann ich mir nicht vorstellen. Ich denke die drei kann man nur über /mnt/xxx/ erreichen (xxx -> addons|disks|remotes).

-

On the "Disk settings" page the following help text needs some more details or clarification IMHO: Shouldn't this be "cache or pool"?